今天的智普又让整个AI界刮目相看了,真的豪爽~

智谱宣布其核心技术链路完全开源!包括:

-

基座模型 GLM-4-32B-0414 -

推理模型 GLM-Z1-32B-0414 -

沉思模型 GLM-Z1-Rumination-32B-0414

另外,小尺寸的 9B 系列同时开源,包括:GLM-4-9B-0414、GLM-Z1-9B-0414 。

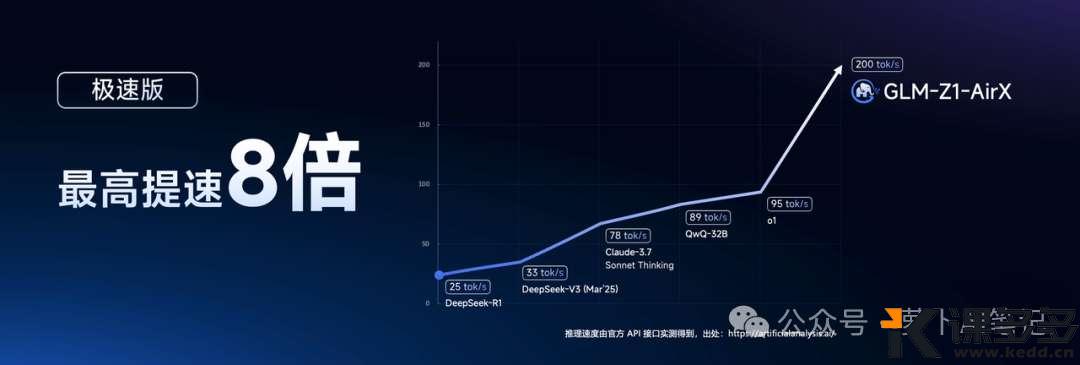

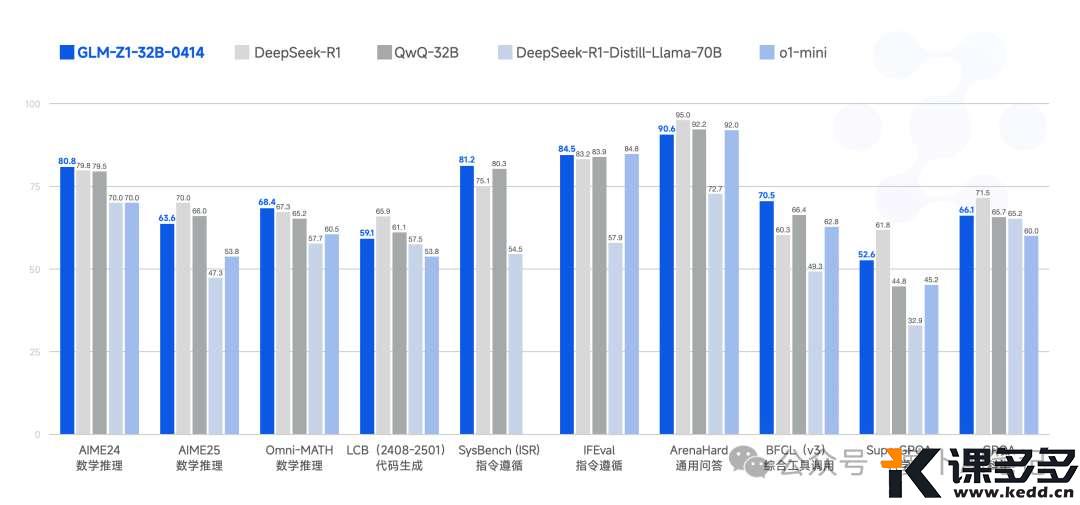

其中 GLM-Z1-32B-0414 推理模型,推理速度最高可达 200 Tokens/秒,成为目前商业模型中速度最快。

GLM-4-32B-0414 支持在对话过程中实时展示生成代码,支持包括 HTML、CSS、JS 和 SVG 在内的语言。无需切换到其它程序,用户一键点击即可在对话窗口实时看到代码运行结果,以便进行灵活的修改与调整。

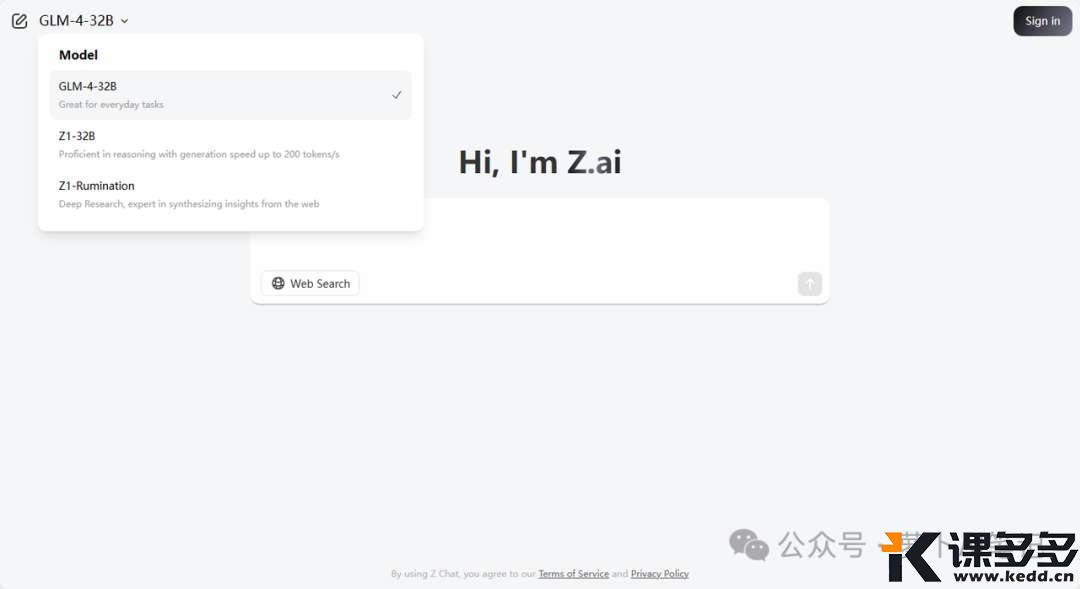

我们可以在智谱 BigModel 开发平台调用 API,价格仅仅是 DeepSeek-R1 的 1/30,也可以在 Z.ai 上免费体验。

访问地址如下:

https://chat.z.ai/

这个顶级域名,是真的豪横啊,不知道要多少钱才拿下的!

除此之外,还同步上线到智谱 MaaS 开放平台,面向企业和开发者提供 API 服务,目前用下面的链接注册,就赠送2000万Token,相当于是送钱了。

https://www.bigmodel.cn/invite?icode=k5Xuh7b9lTOzMG0gFrkexv2gad6AKpjZefIo3dVEQyA%3D

目前上线的推理模型有三个版本,分别满足我们不同场景需求:

-

GLM-Z1-AirX(极速版):定位国内最快推理模型,推理速度可达 200 tokens/秒,比常规快 8 倍; -

GLM-Z1-Air(高性价比版):价格仅为 DeepSeek-R1 的 1/30,适合高频调用场景; -

GLM-Z1-Flash(免费版):支持免费使用,旨在进一步降低模型使用门槛。

不多说了,先来测试一下吧。

推理模型

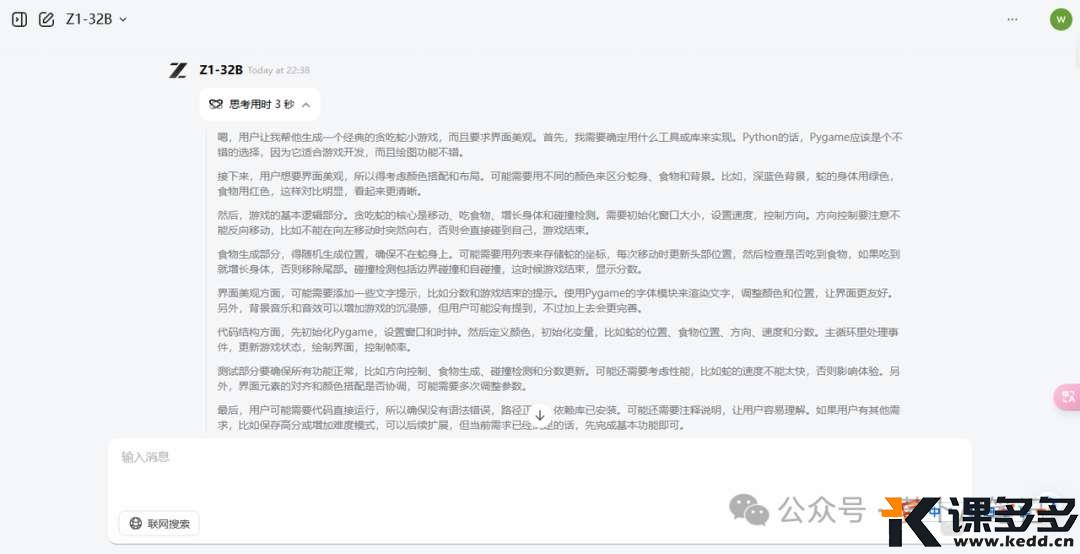

这个号称最快的推理摸GLM-Z1-AirX,可以直接在z.ai网站体验

我们让它写一个经典的贪吃蛇小游戏

帮我生成一个经典的贪吃蛇小游戏,要求游戏界面美观

确实挺快的,仅仅思考了3秒,就开始作答了

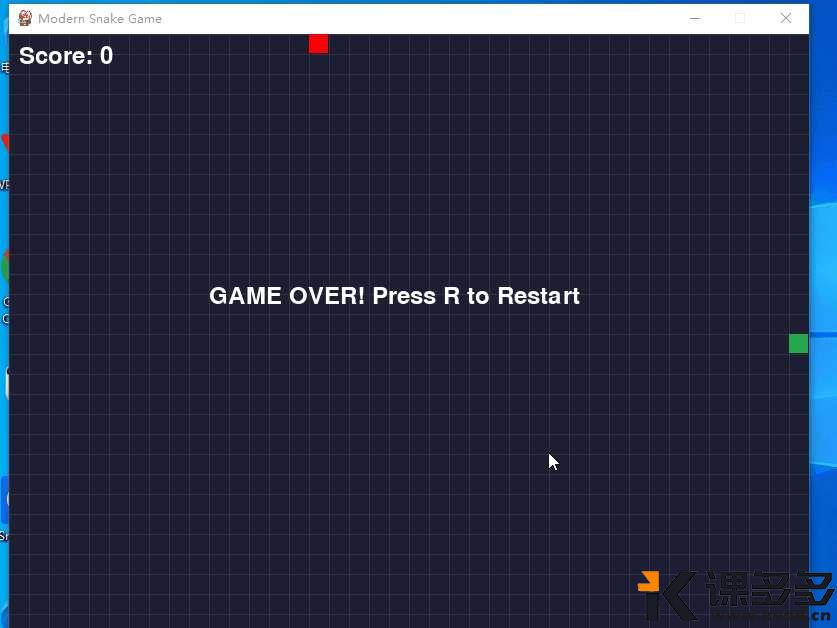

最后的效果也是一次过,直接就能玩,完全不需要调整。

沉思模型

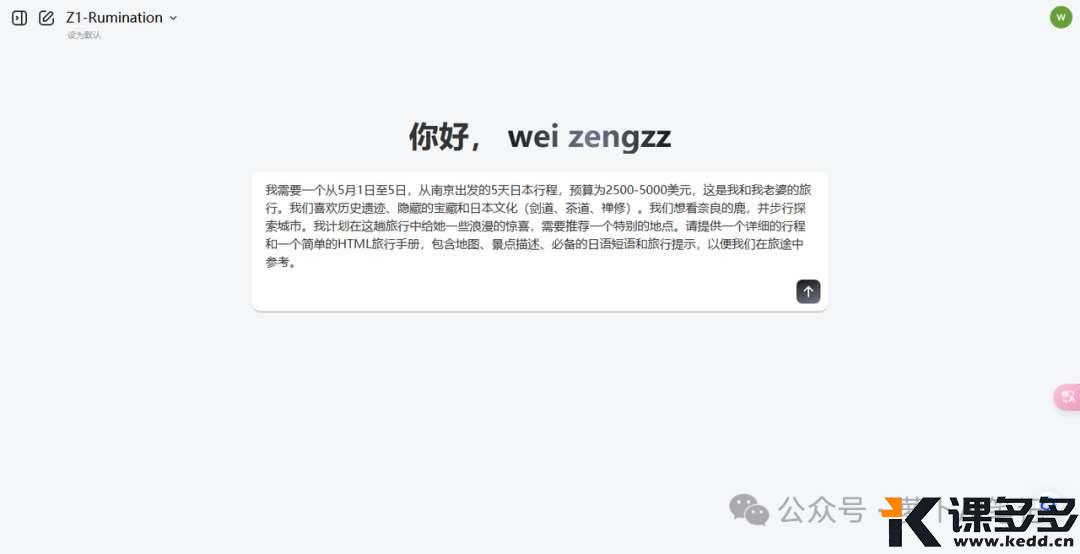

与一般推理模型不同,沉思模型GLM-Z1-Rumination通过更多步骤的深度思考来解开放性的复杂问题。直接上一个例子来看就很清晰了:

我需要一个从5月1日至5日,从南京出发的5天日本行程,预算为2500-5000美元,这是我和我老婆的旅行。我们喜欢历史遗迹、隐藏的宝藏和日本文化(剑道、茶道、禅修)。我们想看奈良的鹿,并步行探索城市。我计划在这趟旅行中给她一些浪漫的惊喜,需要推荐一个特别的地点。请提供一个详细的行程和一个简单的HTML旅行手册,包含地图、景点描述、必备的日语短语和旅行提示,以便我们在旅途中参考。

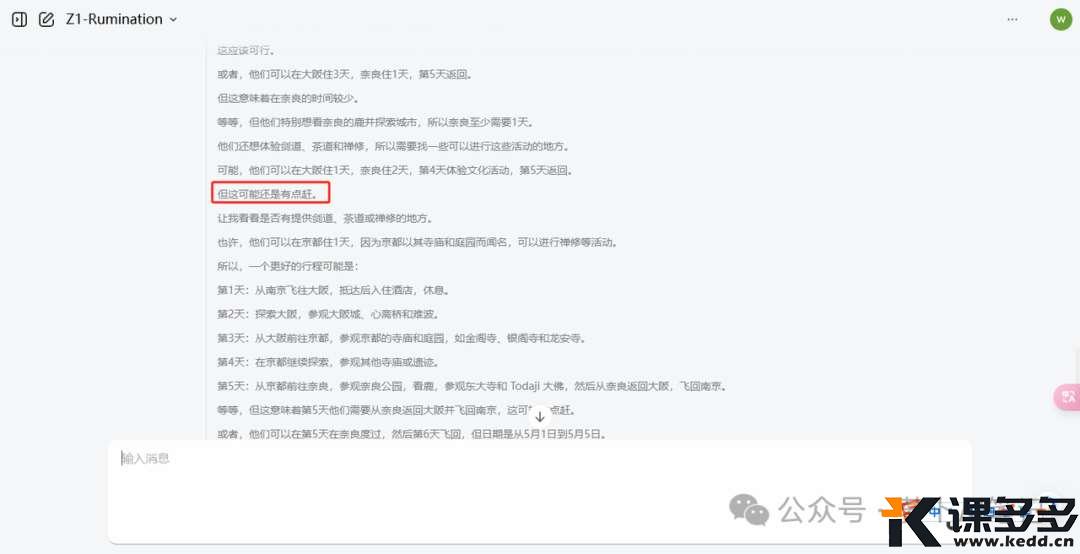

输入问题之后,模型开始上网找资料、做方案,规划行程,组织内容等等。

中间还会自我反思,比如有些行程比较赶,就会做出适当的调整。

几分钟后,一份详细的报告就生成了,很不错哦。

免费体验

当然除了以上介绍的这些模型之外,我们还可以在智普的官方网站上免费体验更多的大模型功能,甚至是AI视频功能哦!

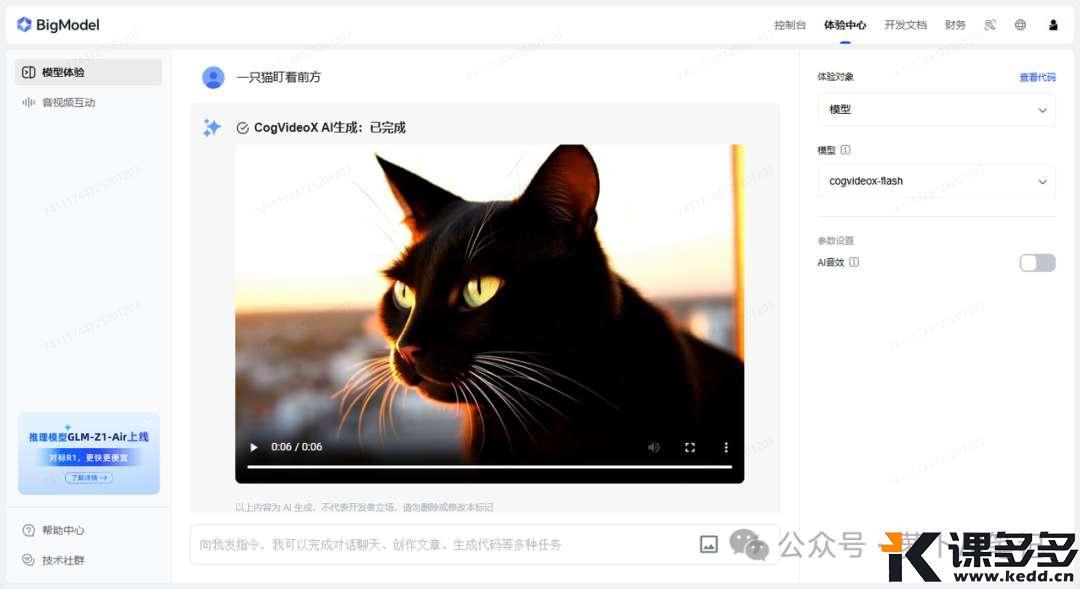

比如文生视频

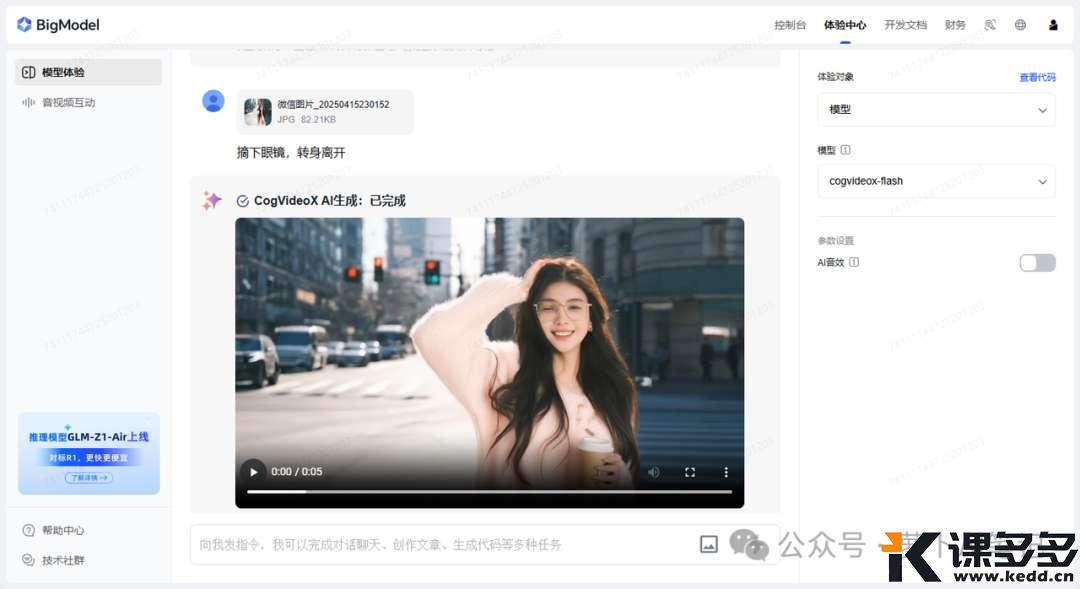

图生视频

不仅免费速度还不赖。

不得不说,作为国内最早开源大模型的公司,真的是一直致力于AI普及,不遗余力呀!

要想体验这些大模型也很简单,直接在下面的链接注册,然后就能免费畅享啦

https://www.bigmodel.cn/invite?icode=k5Xuh7b9lTOzMG0gFrkexv2gad6AKpjZefIo3dVEQyA%3D

写在最后

这一波智普真的上大分,狠狠的吸粉呀!

从DeepSeek掀起开源浪潮之后,智普扛起了这面大旗

开源不是终点,而是新的起点

我们正在见证历史,一个全新的AI时代

每一个开源模型都是通往AGI的铺路石,更是我们普通人实现梦想的阶梯

大模型的未来

从来都不是独行者的游戏

而是拥抱开源的美好明天

暂无评论内容