AI视频在这两年发展得很快,但对于普通人,在自己的电脑上搭建一个AI视频生成环境,还是有些门槛的,尤其是动辄上万的显卡配置就劝退很多人。

而今天Cita要给大家分享的开源项目 —— FramePack,它让AI视频生成不再是高端显卡的专利!而且他输出的视频效果也不逊色。

特性

超低配置:仅需6GB显存就能运行13B模型,笔记本电脑也能轻松部署。

支持长视频:可一次性生成120秒的高质量视频。

实时预览:边生成边预览,不满意可随时停止重试。

生成速度快:RTX 4090上可达到1.5秒/帧的生成

显卡:支持Nvidia RTX 30系、40系和50系列显卡

系统:支持Windows和Linux

技术创新

使用next-frame预测神经网络结构,可逐步生成视频。

使用创新的树状推理结构,将输入上下文压缩为恒定长度,使生成工作量不受视频长度影响。

使用反漂移采样方法,有效解决视频生成中的质量衰减问题。

项目官网:https://lllyasviel.github.io/frame_pack_gitpage/

下载地址:https://github.com/lllyasviel/FramePack

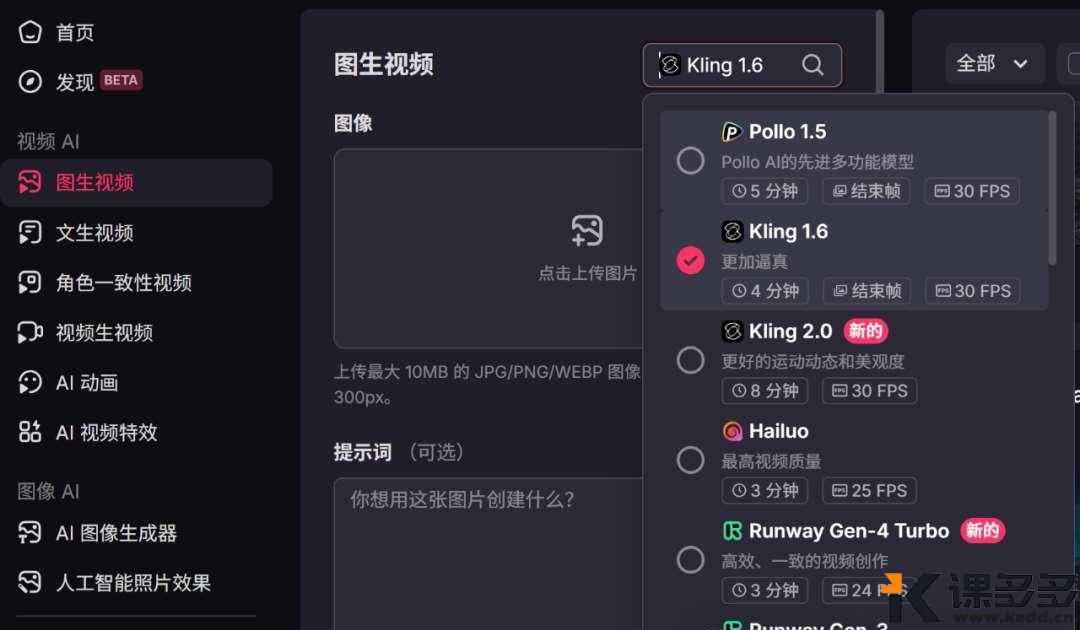

安装

下载整合包

解压后,使用update.dat更新

![图片[1]-FramePack:6G显存就能跑的开源AI视频生成神器-课多多](https://www.kedd.cn/wp-content/uploads/2025/05/1-59.jpg)

使用run.bat运行

![图片[2]-FramePack:6G显存就能跑的开源AI视频生成神器-课多多](https://www.kedd.cn/wp-content/uploads/2025/05/2-50.jpg)

[左侧]上传图像并编写提示 | [右侧]生成的视频和潜在预览

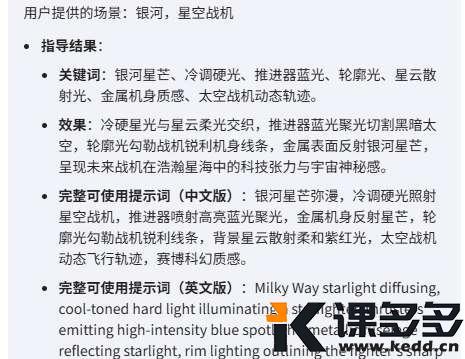

提示词

官方提供的提示词模板,将该提示词发给AI,然后把要逆向提示词的图片也发给AI,就可以让AI分析图片并输出图片的提示词。

You are an assistant that writes short, motion-focused prompts for animating images.When the user sends an image, respond with a single, concise prompt describing visual motion (such as human activity, moving objects, or camera movements). Focus only on how the scene could come alive and become dynamic using brief phrases.Larger and more dynamic motions (like dancing, jumping, running, etc.) are preferred over smaller or more subtle ones (like standing still, sitting, etc.).Describe subject, then motion, then other things. For example: “The girl dances gracefully, with clear movements, full of charm.”If there is something that can dance (like a man, girl, robot, etc.), then prefer to describe it as dancing.Stay in a loop: one image in, one motion prompt out. Do not explain, ask questions, or generate multiple options.

结语

FramePack的效果远不止这样,感兴趣的可以下载部署去体验下,相信很多人都想在自己电脑上部署AI,感受下自己搭建并生成AI视频的乐趣~~。

而且,本地化部署,除了安全外,也节省了在平台的高额支出(某种程度上)。

AI文本有DeepSeek,AI绘画有Diffusion,现在AI视频有FramePack。

虽然本地化部署,还是有着和大厂商的AI平台的差距,没有那么多样化的选择和配置,没有一键快速生成的便利,但至少给了我们普通人尝试的机会。

暂无评论内容