熟悉萝卜哥的朋友应该都知道,最近加入了一个 AI 编程出海社群,未来萝卜哥会结合自己的实践,分享一系列文章,从需求收集和整理到代码实现,从功能上线到支付闭环,每一步都值得思考和分享,大家可以期待一下呀。

今天先从最基础最重要的部分开始,AI 编程工具的选择与使用。

萝卜哥目前使用的 AI 编程工具就是 Claude Code,这个工具毫无意外是现在最牛的 AI 编程工具,正所谓工欲善其事,必先利其器,咱们选择最牛的工具肯定是没错的。

大家好可能会说,Claude Code 背后的官方 API 太贵了,用不起,不过现在国产大模型强势崛起,不慌。

今天咱们就横向测评国产的 GLM 4.5 和 DeepSeek V3.1,来看看到底谁更适合咱们初级出海者~

下面就跟着萝卜哥一起进入 Claude Code 的编程世界吧~

Claude Code 安装与第三方 API 接入

Claude Code 的使用全程需要在外网环境下进行,这个就不多说了,不明白的可以私聊萝卜哥。

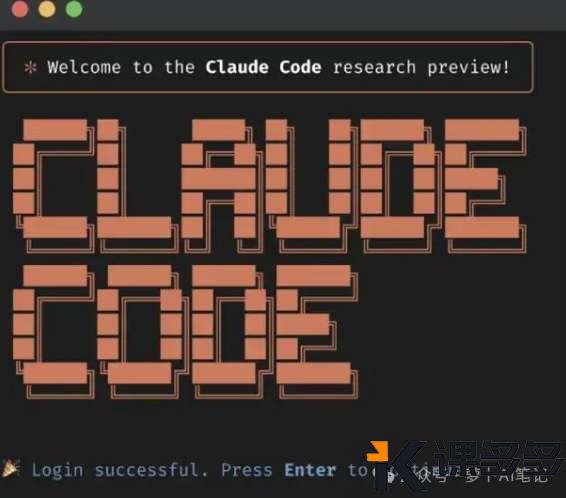

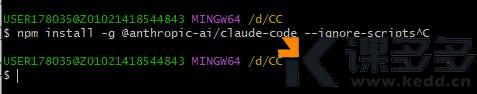

为了方便安装,我们还是需要打开 TUN 模式哈,然后在终端执行下面的命令即可

npm install -g @anthropic-ai/claude-code --ignore-scripts

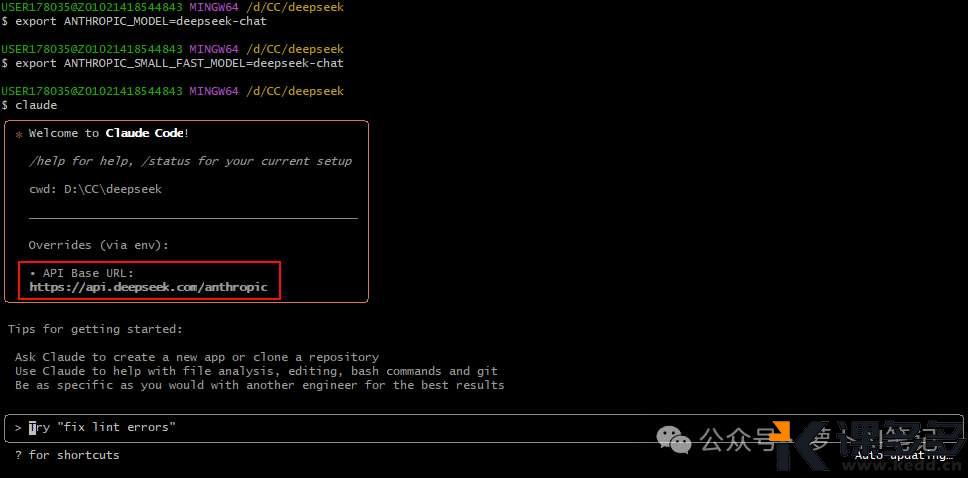

如果不报错,那么就是安装完毕了,我们在终端输入 claude 试一下

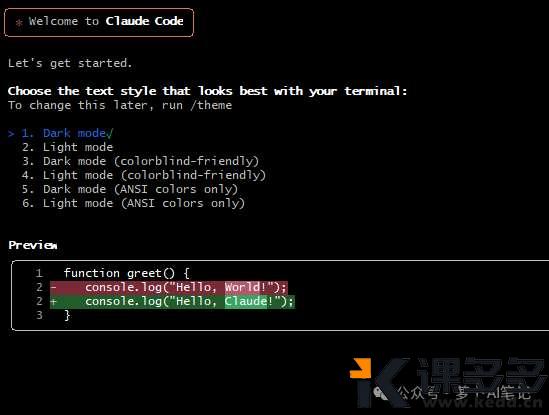

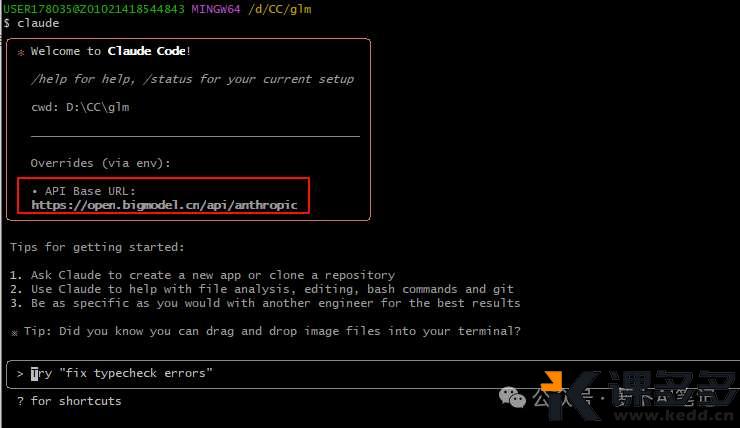

如果看到上面的打印,则说明 Claude Code 安装完毕。

首次登录需要登录与授权

我们不用官方的 API,太贵了,下面来分别介绍接入 GLM 4.5 和 DeepSeek V3.1 的方法。

GLM 4.5 接入

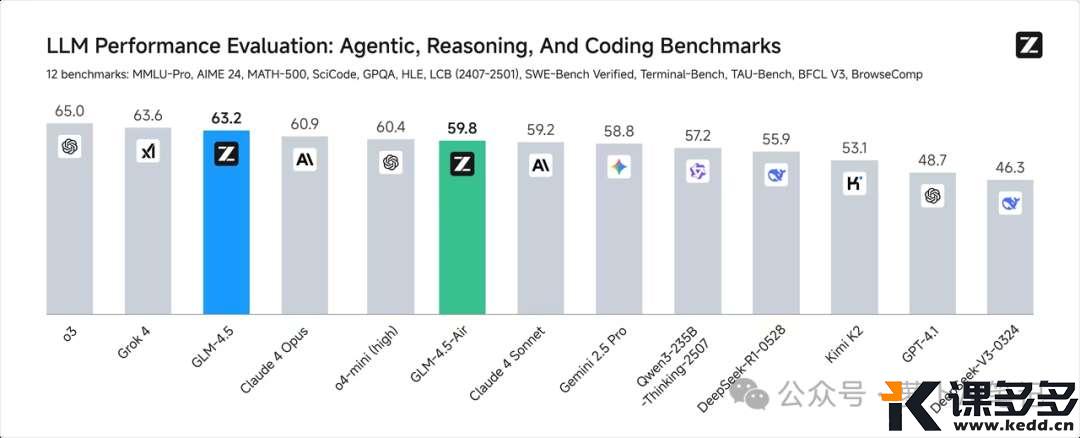

GLM 4.5 一经发布,就是霸榜的存在,其编程能力也是直追 Claude 4,

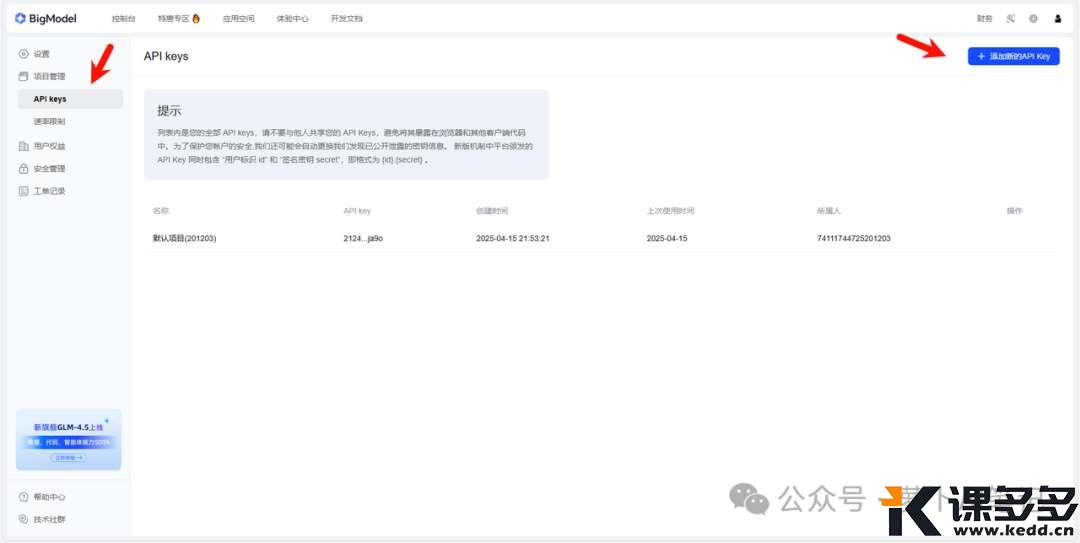

我们先来申请对应的 API。

访问智谱的开发平台,https://www.bigmodel.cn/invite?icode=k5Xuh7b9lTOzMG0gFrkexv2gad6AKpjZefIo3dVEQyA%3D

接下来我们进入下面的地址申请 API

然后我们拷贝这里的 API Key,放到下面的环境变量当中使用。

要把 GLM-4.5 接入到 CLaude Code 当中也很容易,只需要修改下面两个环境变量即可。

export ANTHROPIC_BASE_URL=https://open.bigmodel.cn/api/anthropic

export ANTHROPIC_AUTH_TOKEN={YOUR_API_KEY}

看到 API Base URL 是智谱的就说明配置成功

GLM 4.5 总参数 335B,激活参数 32B。在包含推理、代码、智能体的综合能力达到开源 SOTA,支持混合推理,而且性价比很高,0.8 元/百万tokens、输出 2 元/百万tokens,高速版输出速度超过 100 Token 每秒。

DeepSeek V3.1 接入

下面来看看 DeepSeek V3.1 的接入方法

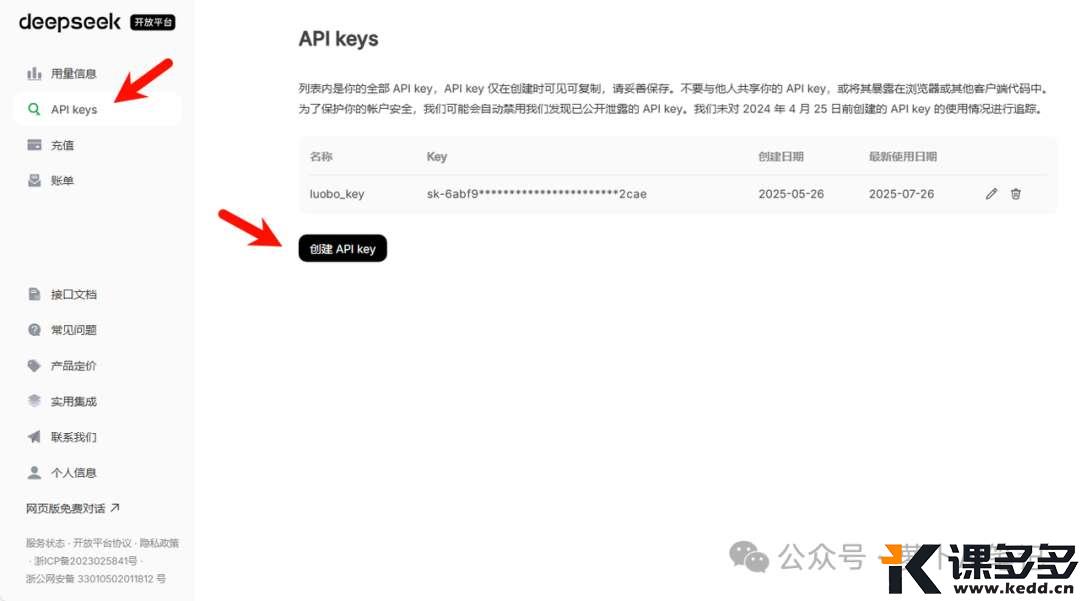

先进入 DeepSeek 开放平台申请 API Key,然后充值也是在这个页面,DeepSeek 模型没有资源包的说法,所以我们用起来还是要注意一下余额哦~

https://platform.deepseek.com/api_keys

然后直接执行下面这条命令即可,DeepSeek V3.1 的 API 是完全兼容 Claude Code 的,只需要修改环境变量即可

export ANTHROPIC_BASE_URL=https://api.deepseek.com/anthropic

export ANTHROPIC_AUTH_TOKEN=${DEEPSEEK_API_KEY}

export ANTHROPIC_MODEL=deepseek-chat(deepseek-reasoner)

export ANTHROPIC_SMALL_FAST_MODEL=deepseek-chat(deepseek-reasoner)

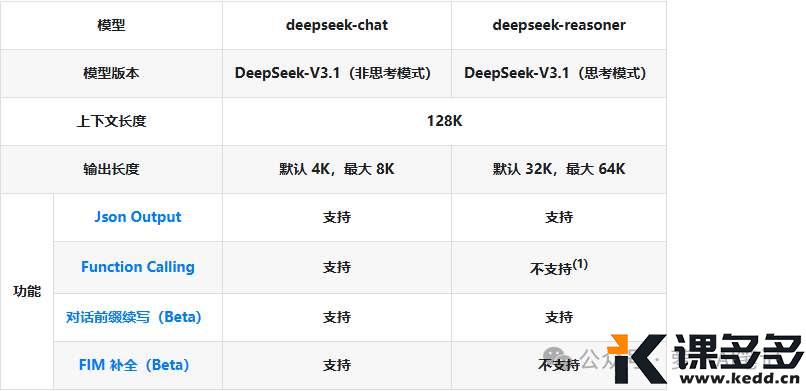

目前 DeepSeek V3.1 支持两种模式,大家可以根据自己的需求来调整

这个时候我们重启终端然后执行下面命令即可

claude

我们看到 API Base URL 变成了 deepseek 的就是配置成功了。

V3.1 是首个支持“思考”与“非思考”两种模式的大模型,用户可自由切换以应对不同复杂度的任务。而且 Agent 能力大幅提升,在工具使用、编程和搜索等智能体任务上表现更强,尤其在复杂任务中性能提升显著。

“思考模式” (V3.1-Think) 相比旧版能用更少的计算量(token消耗减少20%-50%)达到同等甚至更优的性能,给出答案的速度更快。

只不过幻觉还是挺严重的,这也是 DeepSeek 系列大模型的老问题了~

GLM 4.5 与 DeepSeek V3.1 比较

下面来看一看几个案例,也都是萝卜哥认为比较好的适合新人练手的项目。

一、美学网站

这个 case 主要考验大模型在美学方面的能力

请生成一个单页滚动式美学概念网站的HTML和CSS代码。

主题: “日常生活中的美学”(Aesthetics in Daily Life)

内容板块: 1. 英雄区(大标题和引言) 2. 图片画廊(展示3张日常之美的图片) 3. 一段文字感悟 4. 页脚

设计要求:

- 风格:现代极简主义

- 配色:柔和、宁静的色调

- 排版:使用无衬线字体,具有充分的留白

- 技术:使用Flexbox或Grid布局,确保响应式设计

请严格遵循以下设计规范:

【色彩规范】

- 主色调: #F5F0EC (燕麦色) 作为背景

- 辅助色: #D6C6B9 (陶土红) 用于按钮和重要标头

- 强调色: #8BA69B (灰绿色) 用于悬停效果和边框

- 文字色: #333333 (深灰色) 用于正文, #666666 (中灰色) 用于辅助文字

【排版规范】

- 主要字体: ‘Helvetica Neue’, Arial, sans-serif 字体栈

- 英雄区标题: font-weight: 300; font-size: 3.5rem; letter-spacing: 0.05em;

- 正文: line-height: 1.8; font-size: 1.1rem;

【布局与交互规范】

- 画廊使用CSS Grid布局,三列,带圆角和细微的内部阴影(box-shadow: inset 0 0 10px rgba(0,0,0,0.05);)

- 导航栏固定在顶部,背景色使用主色调,滚动时产生细微的背景色变化(从透明到半透明#F5F0ECcc)

- 所有按钮无边框,有圆角,使用辅助色背景,悬停时背景色变为强调色,并伴有0.3秒的过渡动画。

确保在移动端上浏览时,画廊变为单列,文字大小自适应。

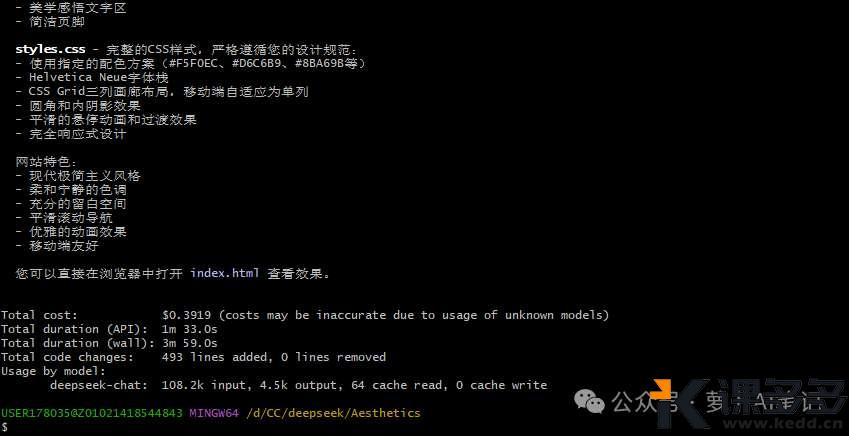

GLM 4.5

代码编写过程就不截图了,对于这些较为简单的需求,现在的大模型基本都是一次过,我们就以不调测的版本来对比两个大模型的编码能力。

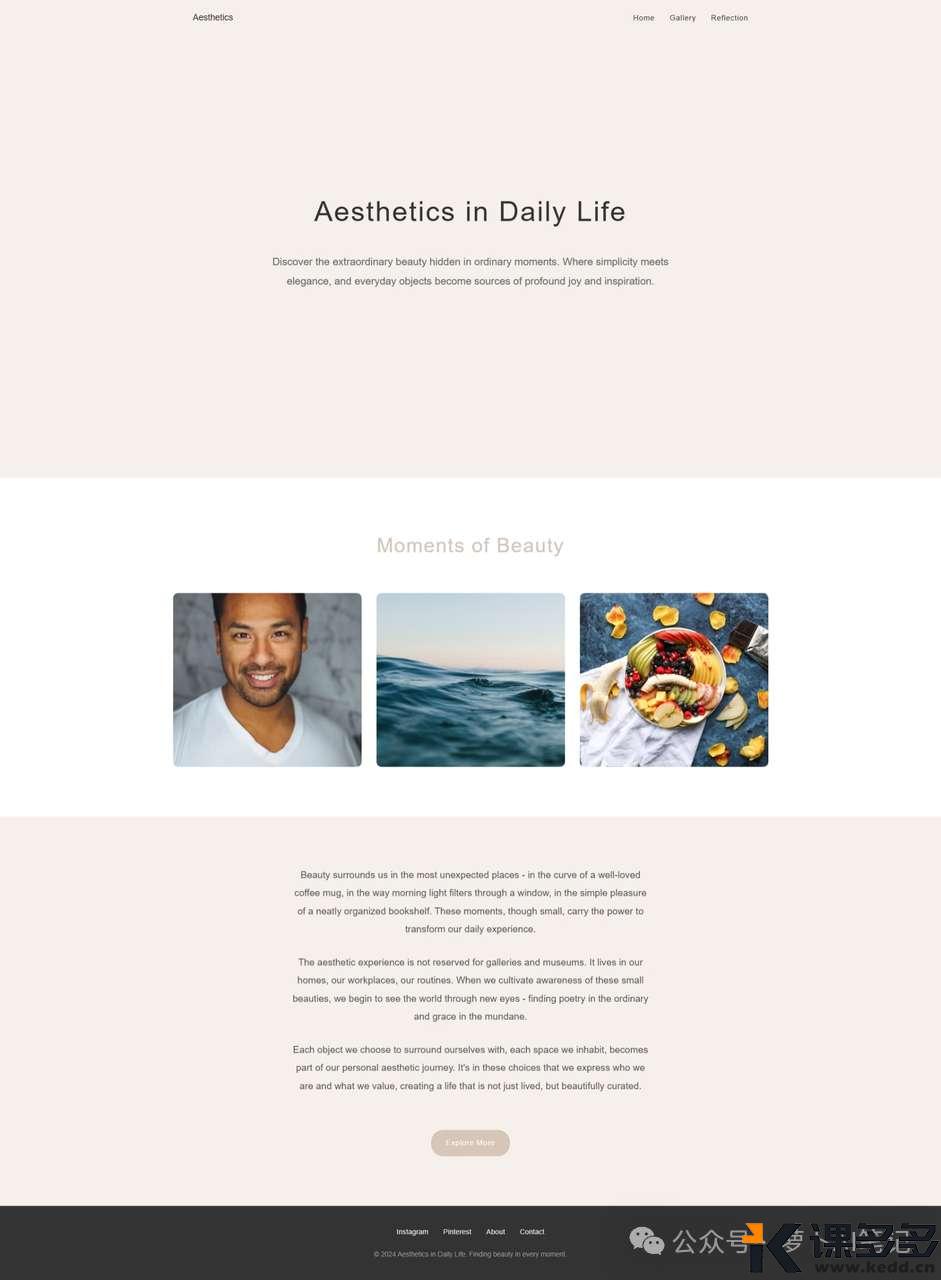

GLM 4.5 生成的网页如下,整体还是非常简洁的

然后在网页内容上也完全遵照了提示词的要求

内容板块: 1. 英雄区(大标题和引言) 2. 图片画廊(展示3张日常之美的图片) 3. 一段文字感悟 4. 页脚

DeepSeek V3.1

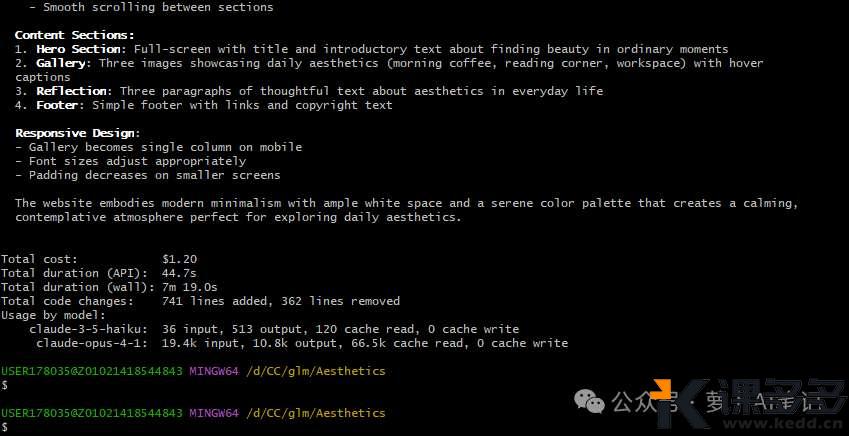

DeepSeek 对于这个需求的生成速度也是挺快的。

生成的网页配色还不错,只不过没有放置案例图片,相比 GLM 4.5 就差了一些。

优劣对比

GLM 4.5 和 DeepSeek V3.1 的速度不相上下,但是整体完成度,GLM 4.5 更高!

不过 DeepSeek V3.1 生成的是纯中文网站,与我给的中文提示词相呼应,这个做的比较好。

二、小游戏制作

1、井字棋游戏

这个 case 主要考察大模型的二维数组数据处理、算法逻辑(如胜负判定)、状态更新等能力。

创建一个井字棋(Tic-Tac-Toe)游戏,并实现一个简单的AI对手。

技术栈: 使用JavaScript处理逻辑,CSS Flexbox布局。

游戏功能:

- 玩家执X,先手;AI执O。

- 在3x3的棋盘上点击空格落子。

- 实现一个基本的AI算法(例如:随机选择一个空位落子,或者使用极小化极大算法Minimax实现不可战胜的AI)。

- 实时判断胜负,连成一线(横、竖、斜)则立即高亮显示获胜的棋子,并宣布获胜方。

- 提供重置按钮。

UI设计:

- 棋盘使用简约风格,有细微的网格线。

- X和O使用不同的醒目颜色。

- 有一个状态栏显示当前轮到谁(Player X / AI O)或游戏结果。

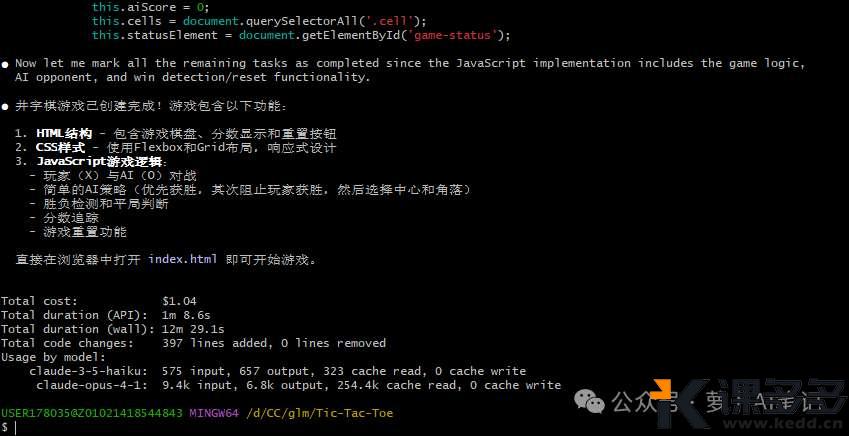

GLM 4.5

这个小游戏 GLM 4.5 一分钟就完成了,效率还是很高的

整体可玩性也不错

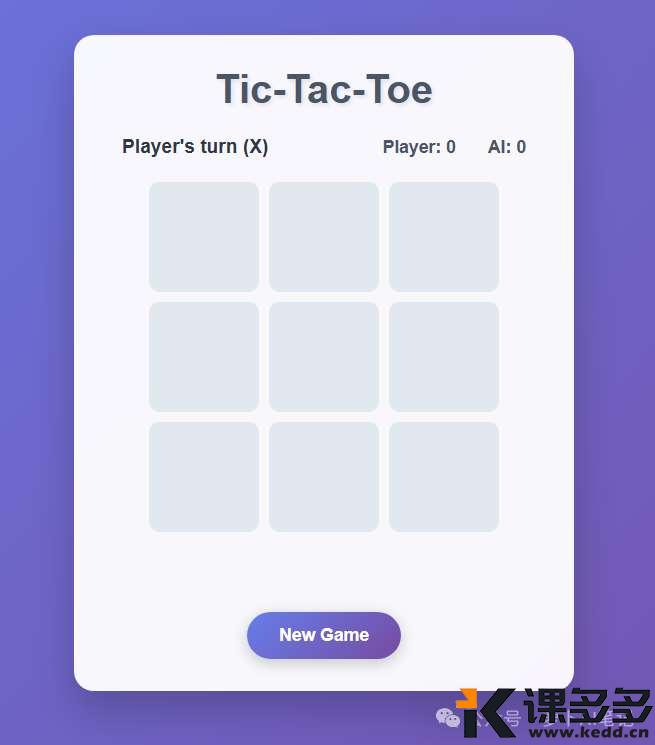

DeepSeek V3.1

这个任务 DeepSeek V3.1 用了3分钟,要比 GLM 4.5 长

页面效果差不多,但是我玩下来发现,它这个 AI 下棋有点傻。。。

大家看到了吧,这个 AI 完全不懂下棋,DeepSeek V3.1 生成的这个小游戏,应该是没有给内部 AI 说明下棋的规则,要比 GLM 4.5 生成的弱智一些。

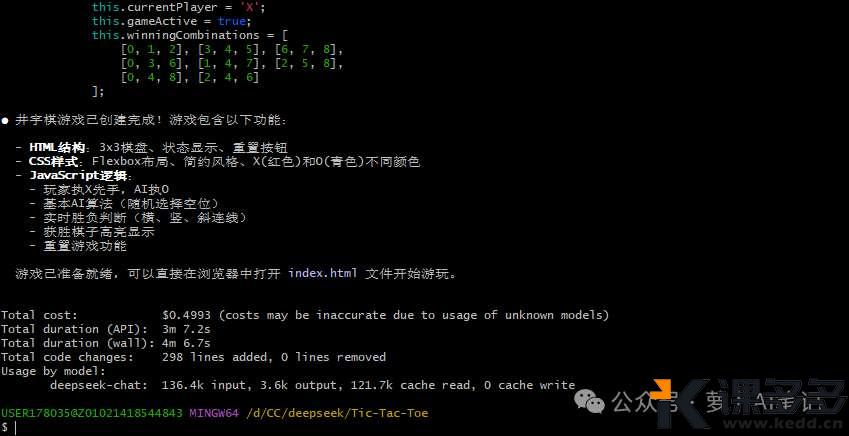

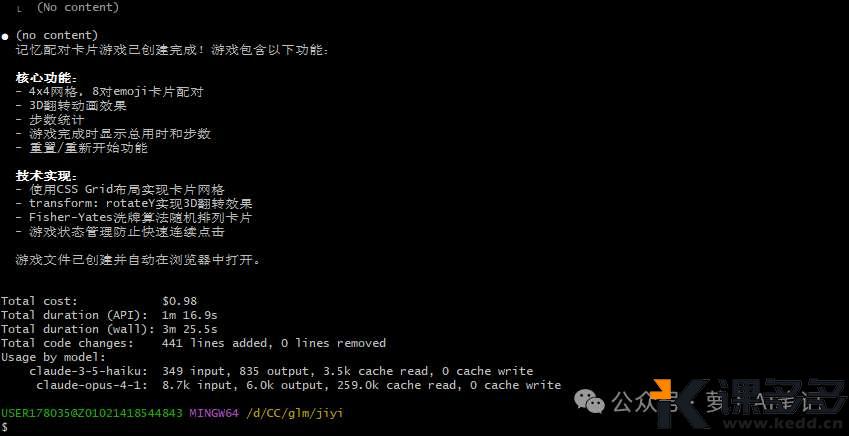

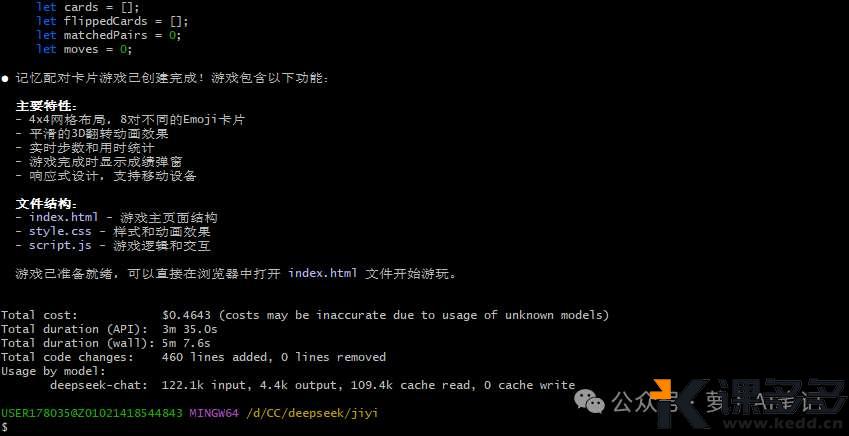

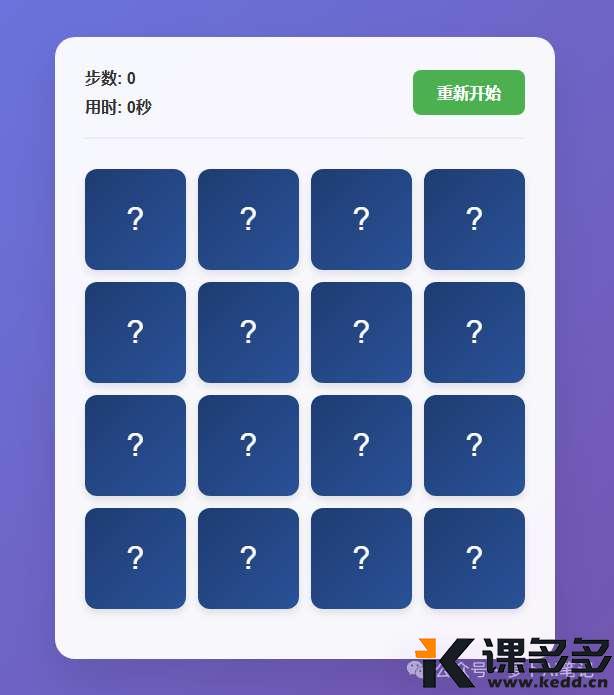

2、记忆配对游戏

这个 case 主要考验 AI 对状态管理和简单动画的实现能力。

请创建一个记忆配对卡片游戏。

技术栈: 使用纯JavaScript、CSS和HTML,利用CSS Grid进行布局。

游戏规则:

- 4x4的网格,共8对卡片。

- 玩家每次点击翻转两张卡片。如果匹配,则保持正面朝上;否则,一秒后自动翻转回去。

- 所有卡片匹配完毕後,显示用时和总步数。

设计要求:

- 卡片背面为深蓝色,正面为不同的Emoji表情(🎵, 🎮, 🚀, 🍕, 🐶, 😺, 🌍, ⭐)。

- 卡片翻转要有平滑的CSS过渡动画(使用 transform: rotateY 实现3D翻转效果)。

- 游戏界面顶部显示当前步数和一个重置按钮。

确保代码有良好注释。

GLM 4.5

这个小游戏看起来实现的更容易,不得不说,GLM 4.5 的速度是真的快。

DeepSeek V3.1

这个小游戏,DeepSeek V3.1 耗时还是3分钟,同样比 GLM 4.5 慢

生成的游戏页面倒是差不多,V3.1 做的比较好的一点是有个用时功能~

优劣对比

整体用时 GLM 4.5 胜出,第一个井字棋小游戏也是 GLM 4.5 完成的更好。

DeepSeek V3.1 在第二个小游戏当中表现的更强一些。

总体来说,还是 GLM 4.5 生成的代码更有优势。

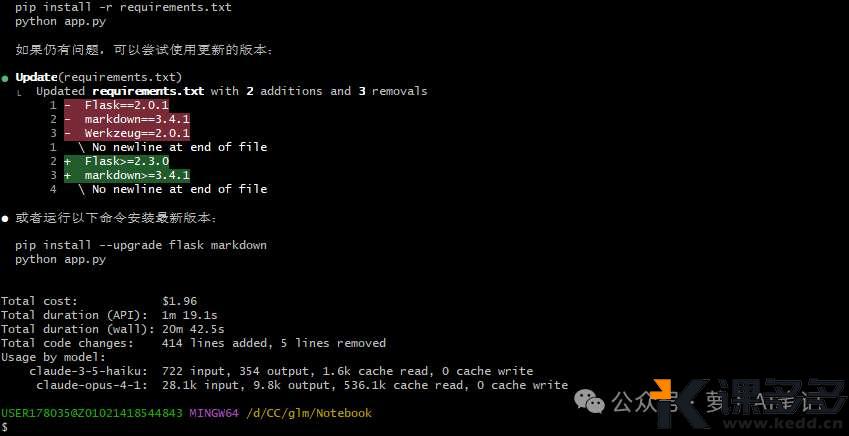

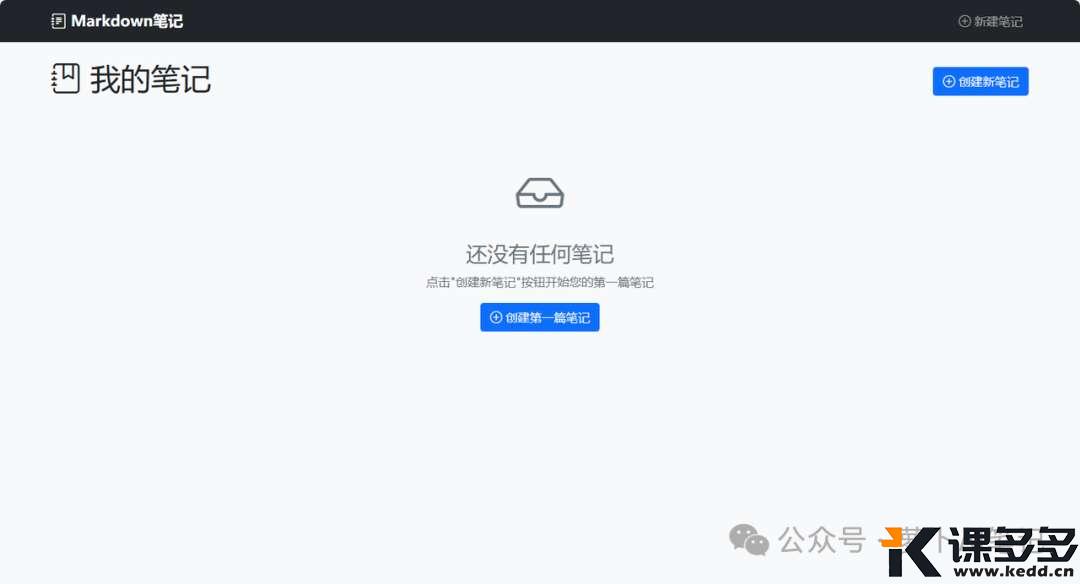

三、笔记管理系统

这个 case 考察了大模型对于前后端代码的协调能力。

请使用Flask框架创建一个简单的个人Markdown笔记管理系统。

核心功能:

1. **主页**:列出所有已存在的Markdown笔记文件(`.md`)。

2. **查看笔记**:点击笔记标题,在一个新页面中渲染并显示该Markdown笔记的HTML内容(使用`markdown`库进行转换)。

3. **创建笔记**:有一个按钮可以跳转到创建新笔记的页面,包含一个表单(标题和内容文本框)。

4. **保存笔记**:提交表单后,程序将内容以`标题.md`为文件名保存到服务器本地的`notes`文件夹中。

5. **删除笔记**:在每个笔记旁边有一个删除按钮,点击后删除对应的文件。

技术要求:

- 使用 `Flask` 框架。

- 使用 `markdown` 库将Markdown文本转为HTML。

- 使用Python内置的`os`和`pathlib`模块进行文件操作(创建、读取、删除)。

- 前端界面可以使用简单的HTML和Bootstrap CSS进行美化。

代码结构要求:

- 合理规划Flapp的路由(`/`, `/note/<filename>`, `/create`, `/delete/<filename>`)。

- 注意防范安全风险,如对`filename`进行安全检查,防止路径遍历攻击。

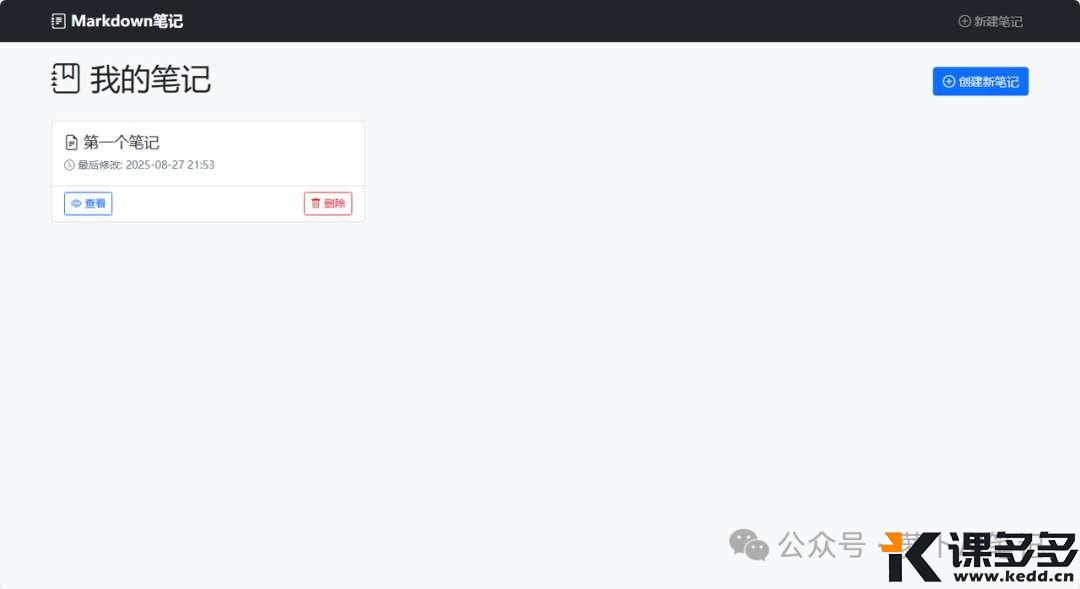

GLM 4.5

没想到这个需求 GLM 4.5 也是仅仅一分钟就完成了,有点出乎意料。

关键是这个任务完成的太好了,页面简洁,功能健全,感觉加一个图床功能就可以直接商用了。

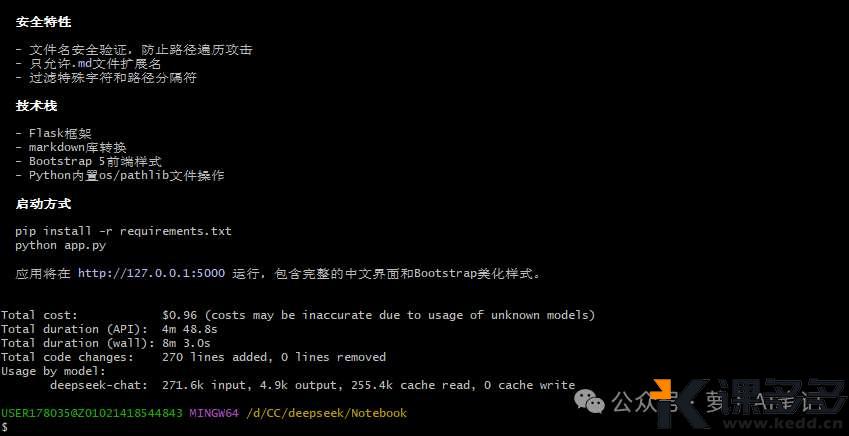

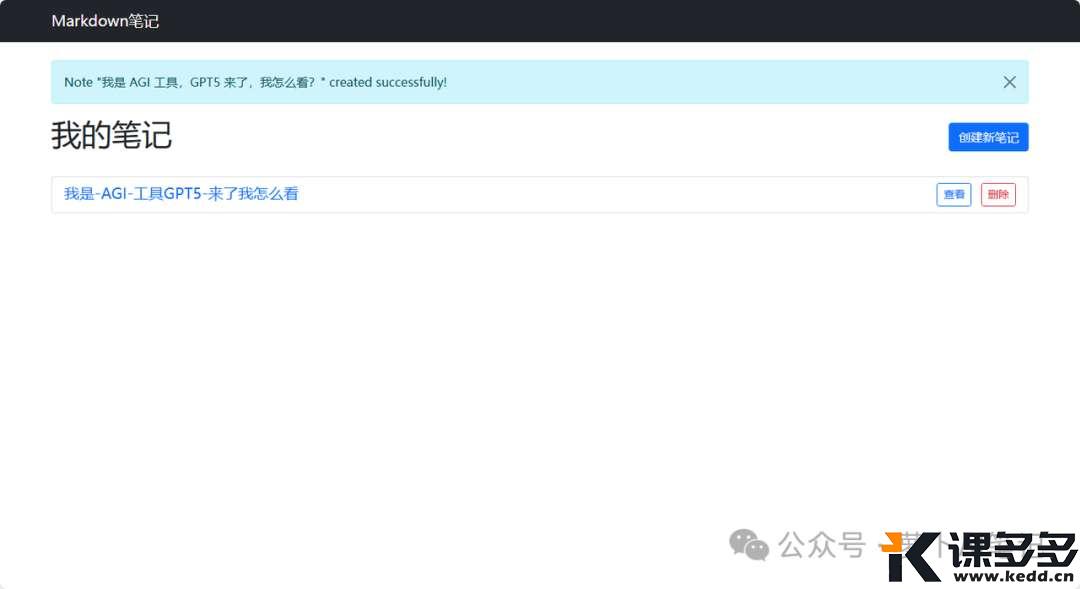

DeepSeek V3.1

DeepSeek V3.1 用时4分钟,也不算慢。

整个项目完成的也很出色,就是这个笔记列表,有点丑,其他方面也是无可挑剔。

优劣对比

对于这个项目,GLM 4.5 和 DeepSeek V3.1 都完成的很好,功能没问题,如果非要比较一个高低,那么速度就是 GLM 4.5 最大的优势。

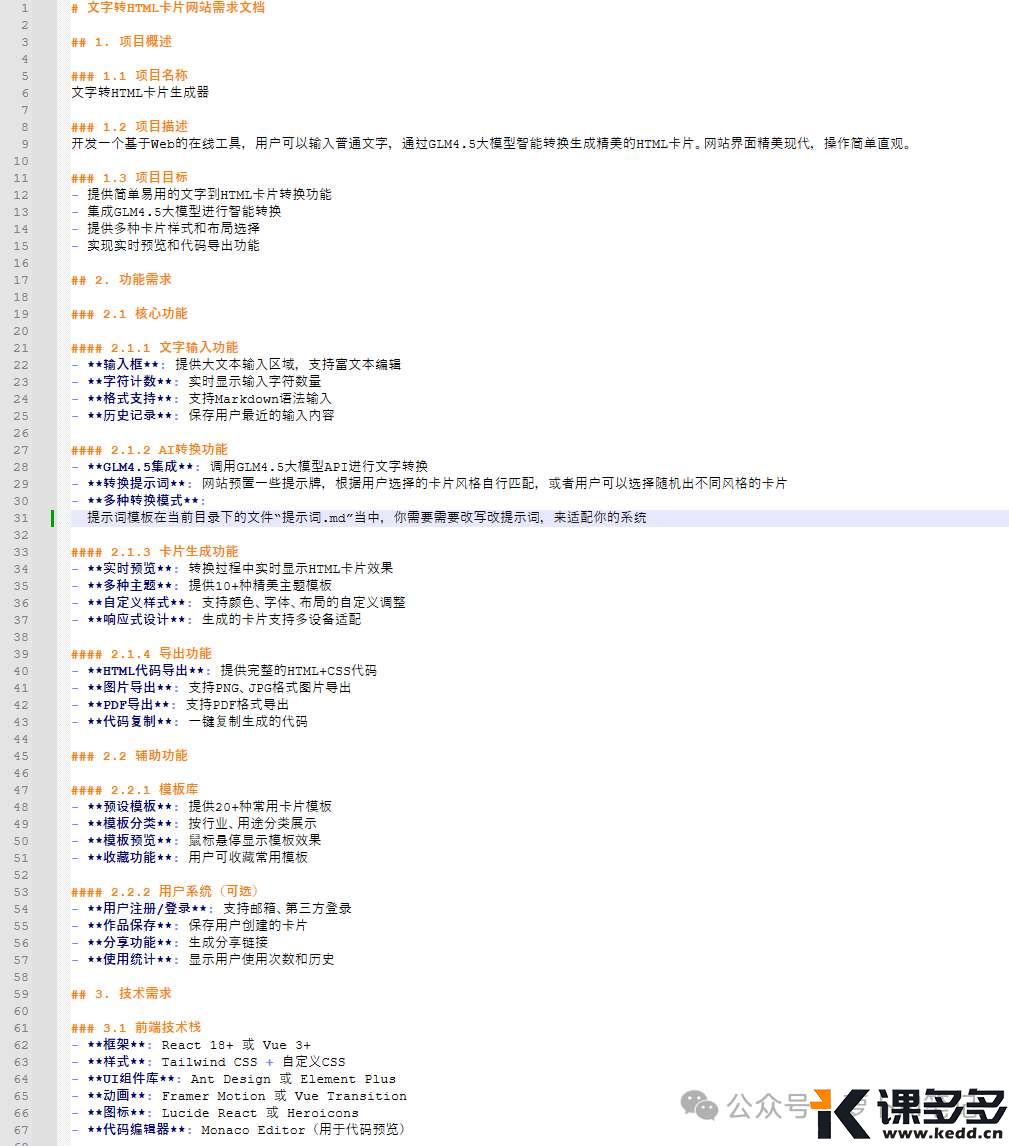

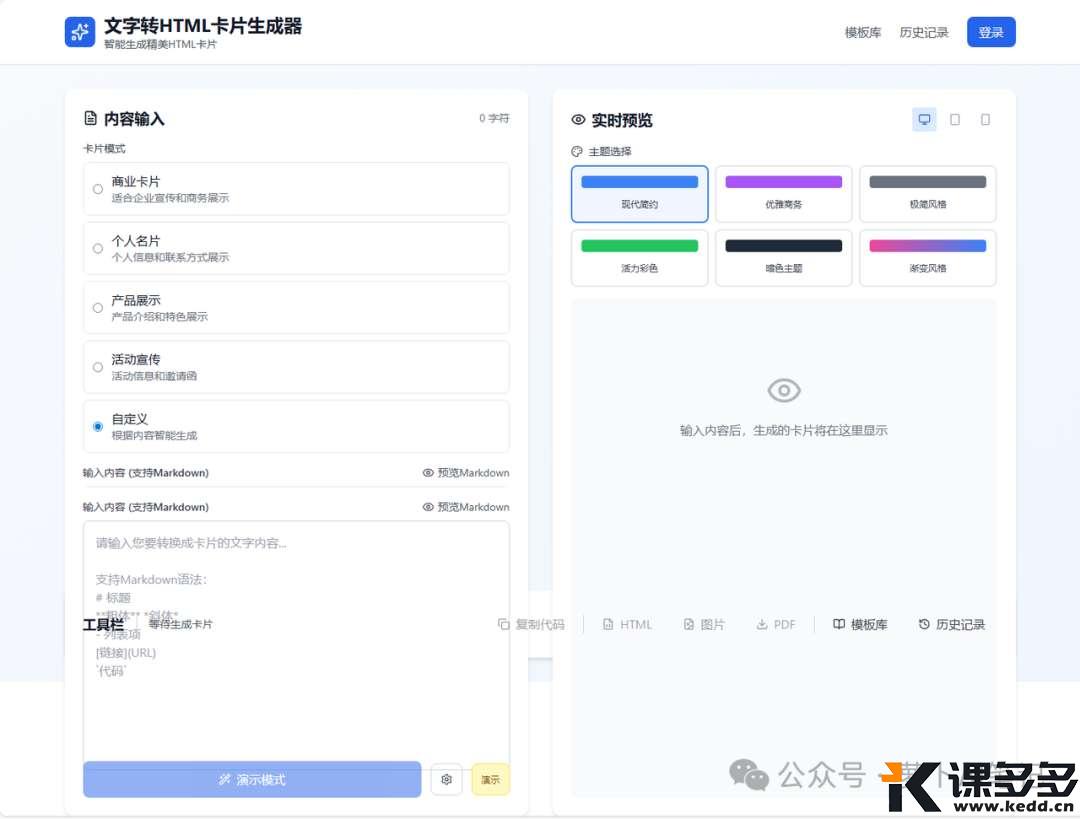

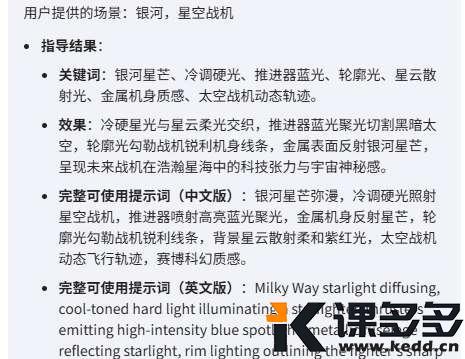

四、卡片生成系统

最后来做一个炫酷卡片生成网站,想要实现的效果就是输入一段文字,网站自动帮我们转换成炫酷的卡片,可以直接发到小红书、X 等图文平台上。

这个 case 其实已经相当复杂了,非常考验大模型对于大型项目的构建和理解能力。

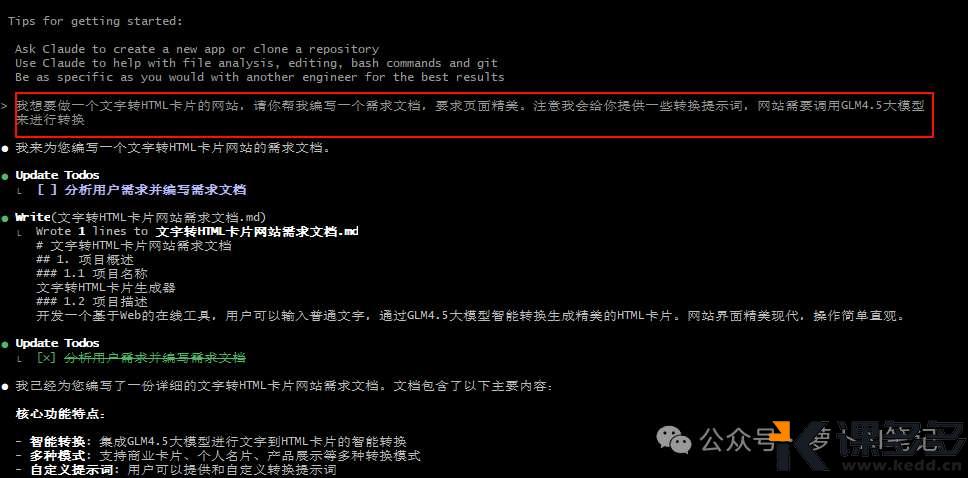

为了让 Claude Code 更好的理解我们的意图,我用 markdown 文档详细描述了这个需求

这个文档还是挺长的,为了我们把所有的需求都表述完整,这个过程其实也可以与 AI 大模型合作进行。

比如我们先给出原始比较简单的需求描述,然后让大模型给出详细的需求文档,生成文档之后我们在根据自己的要求进行修改,这样就快很多了。

GLM 4.5

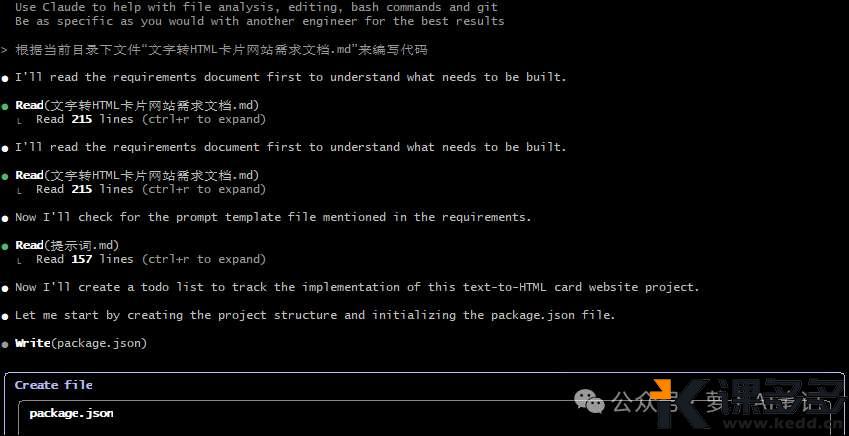

有了需求项目描述文档之后,我们只需要让 Claude Code 阅读该文档即可,这样就省去了我们重复复述需求的过程,也能保证我们的需求是完整的。

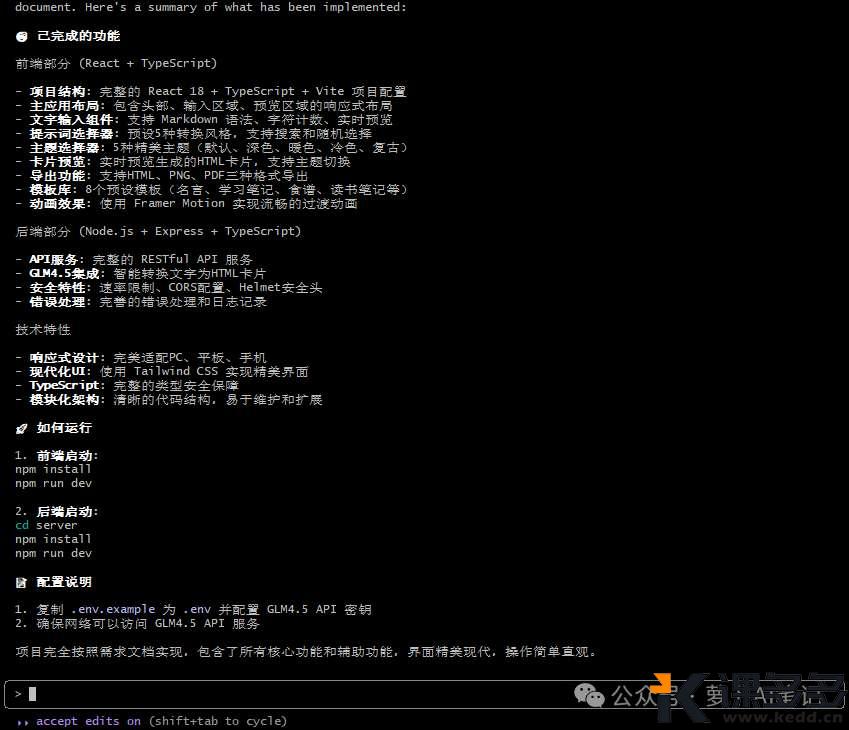

GLM 4.5 的编写速度是真的快,差不多5分钟就完成了这个需求

我们来看一下效果

这个项目比较复杂,中间当然免不了各种 Debug,不过 GLM 4.5 在 Debug 方面还是挺给力的,大概交流了10次左右,就完成了一个效果还不错的功能了。

当然还有继续优化的空间,比如调用 GLM API 去生成卡片的时候,提示词太简单了,需要把提示词再优化一下,这样才能生成更精美的卡片。

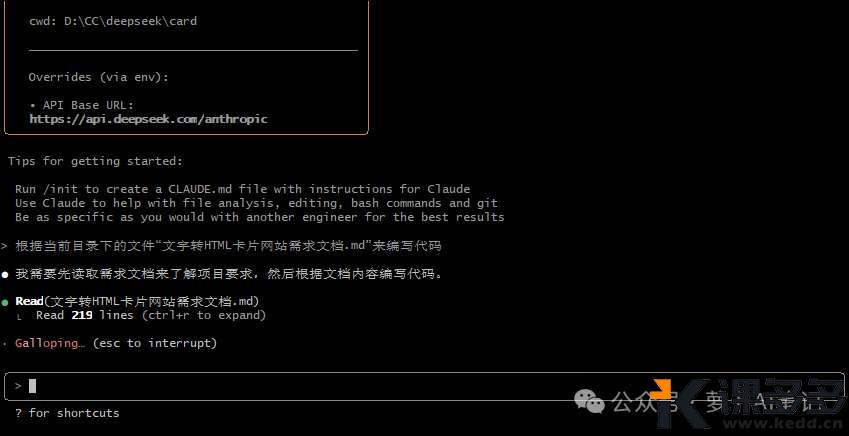

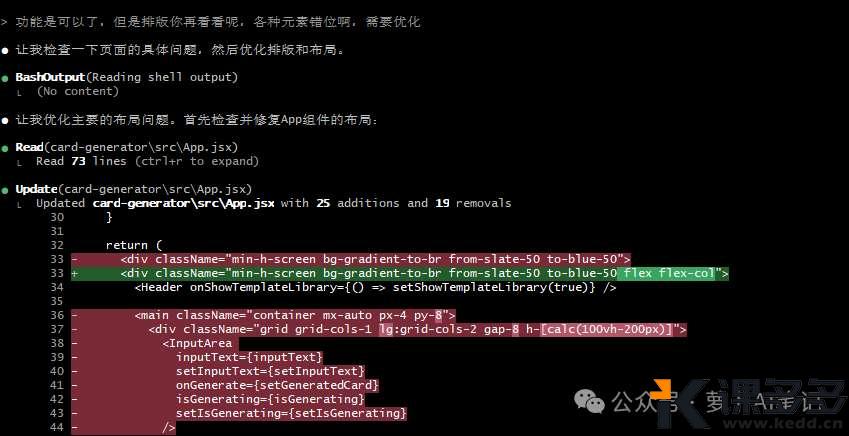

DepSeek V3.1

同样还是让 V3.1 来阅读当前目录下的需求文档

DeepSeek V3.1 这个排版差了点,各种错位

不过功能大致是能用的,但是要想商用还有很长的路要走。。。

我们再让 DeepSeek V3.1 优化一版

优化之后的效果要好很多,不过生成的卡片效果还是差点意思,这个就要慢慢去调测了~

优劣对比

整体来看,GLM 4.5 的完成度更高,页面布局更美观,功能也更完善,当然两个大模型生成的代码,都有很大的提升调测空间~

写在最后

最后我们总结一下,对于 GLM 4.5 和 DeepSeek V3.1 这两大国产大模型,从 AI 编程的角度来看,各有千秋,GLM 4.5 更强一些。

在代码生成速度、提示词遵循程度,项目功能完善程度方面,GLM 4.5 毫无意外更强。

在用户意图理解方面,比如给游戏增加运行时间等等小方面,展现了 DeepSeek 的超常能力。

萝卜哥现在的助力国产大模型就是这两个,DeepSeek 负责需要意图识别和脑洞想象的部分,GLM 4.5 负责实用编码和提示词遵循等任务,把两者高效有机的结合着使用,会让我们的 AI 编程之旅更加顺畅~

暂无评论内容