早就听说腾讯要搞自己的 AI 编程 IDE,等了好久,最近终于发布了

可以访问他们官网查看,https://www.codebuddy.ai,虽然现在还是邀请机制,不过萝卜哥也给大家拿到了一些免费邀请码,文末获取哈~

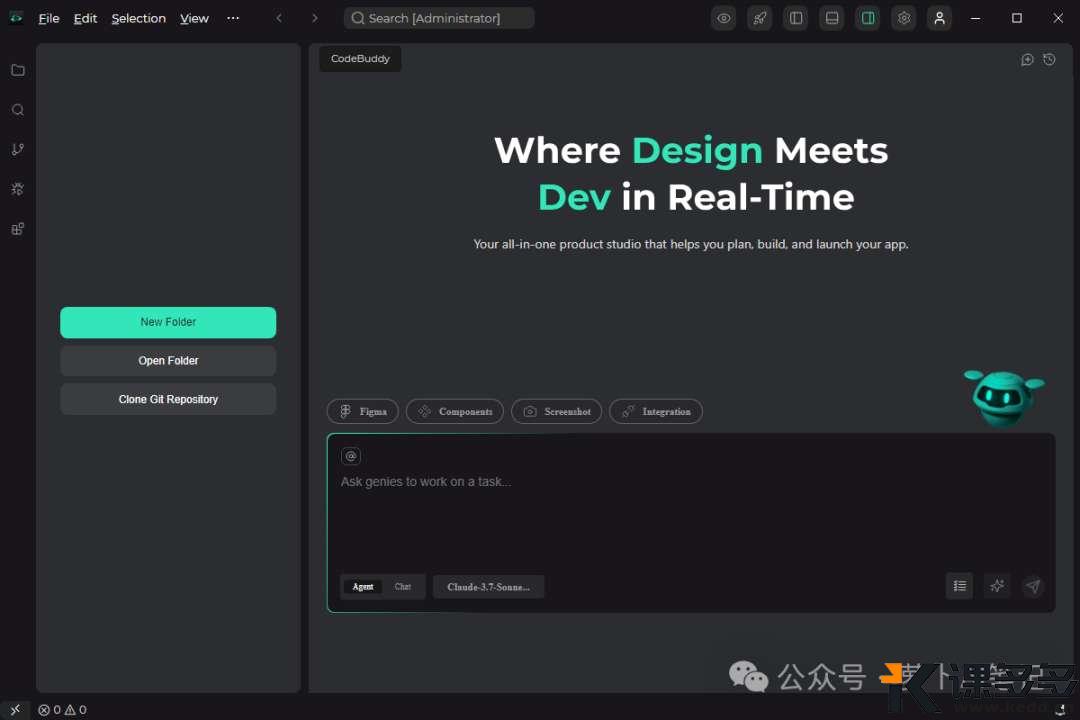

萝卜哥这里已经提前体验过了。

先说结论:整体良好,超出预期!我觉得完全可以比肩 Cursor 和 Trae。

制作浏览器插件

一直想写一个顺手的浏览器插件,把平时常用的功能都放进去这样就不用来回切换页面了。正好用 CodeBuddy 来练练手,看看效果。

我想要开发一个浏览器插件,主要功能是调用大模型API,根据用户划词来拓展或者翻译、解释等等功能,请你帮我生成readme文档以及设计文档,最终给出完整代码。插件需要适配Chrome和Edge两个浏览器

可以看到我的提示词不复杂,基本就是自己需要什么就写什么。

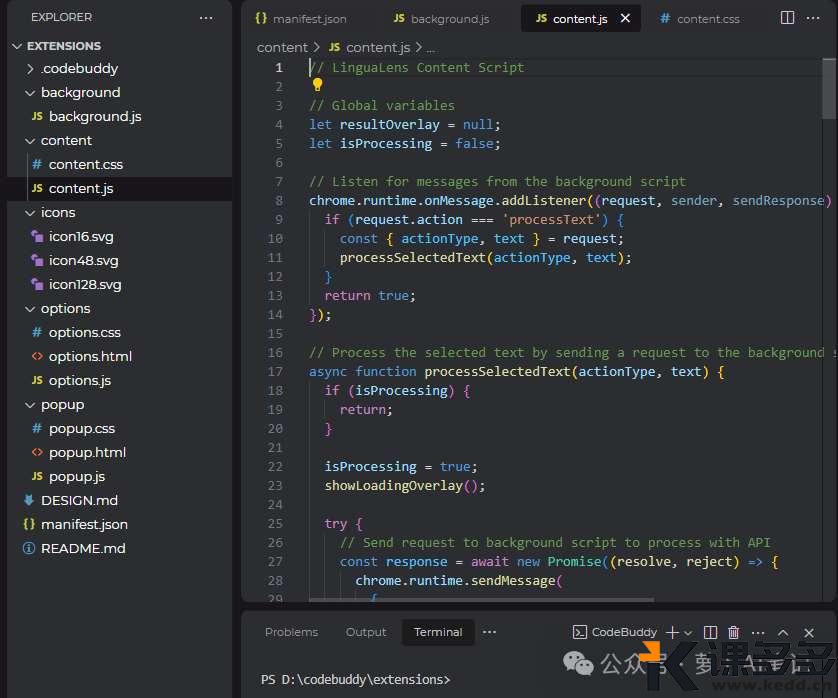

很快 CodeBuddy 就完成了代码的编写,一个浏览器插件的基本功能都包含了

我们来看看几个主要文件的作用:

-

manifest.json:配置文件,定义插件的元数据和权限。 -

popup.html:弹出窗口的HTML。 -

popup.js:弹出窗口的逻辑代码。 -

content.js:操作网页内容的脚本。 -

background.js:后台运行的脚本。 -

options.js:插件的配置项,比如选择 API 供应商等等。

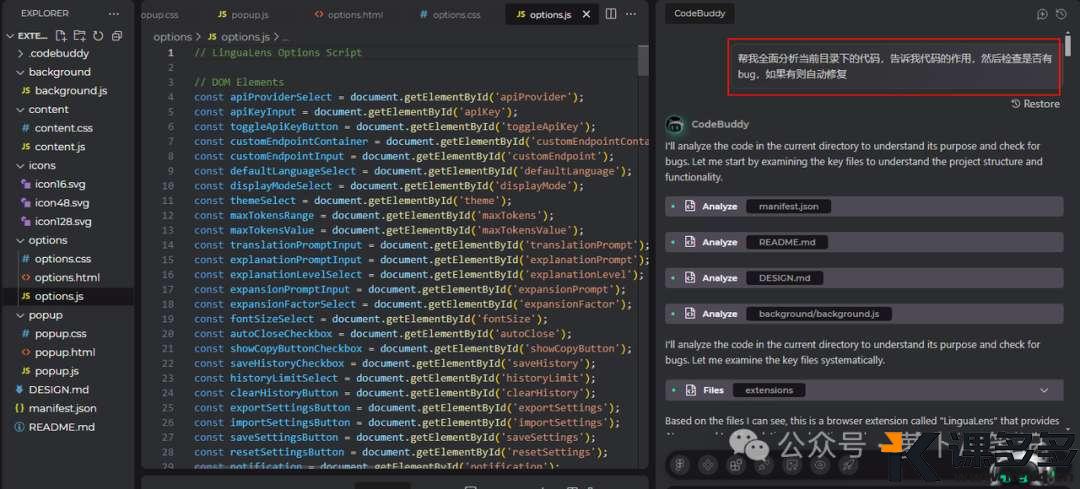

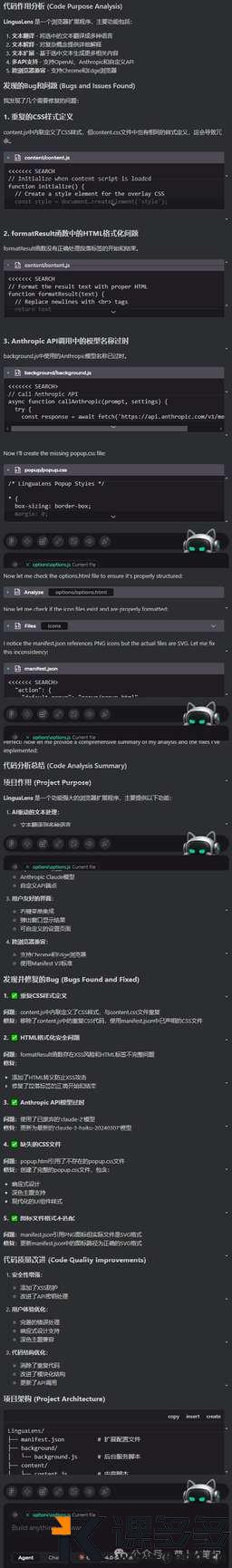

然后因为萝卜哥这里拿到的是内测的版本嘛,功能还不稳定,而且内测版本更新迭代也非常快,当我再一次拿到最新的内测版本之后,我第一时间让新版本来优化前面的代码。

CodeBuddy 会先分析整个目录下的代码,然后根据代码用途进行针对性的 debug。可以千万不要小看这个功能啊,这对于我们阅读别人的代码“屎山”来说,用处可太大了!

可以看到 CodeBuddy 很准确的分析出代码的用途,并且给出了很不错的优化建议。

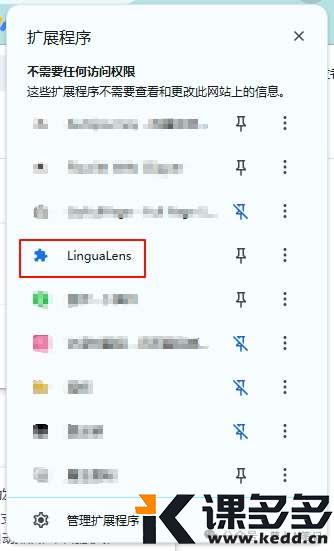

接下来我们打开 Chrome 的插件页面,chrome://extensions/,先打开开发者模式

然后把本地整体的差距代码文件夹拖拽到这个页面即可

这个时候我们在浏览器插件页面就能看到刚刚安装的插件了

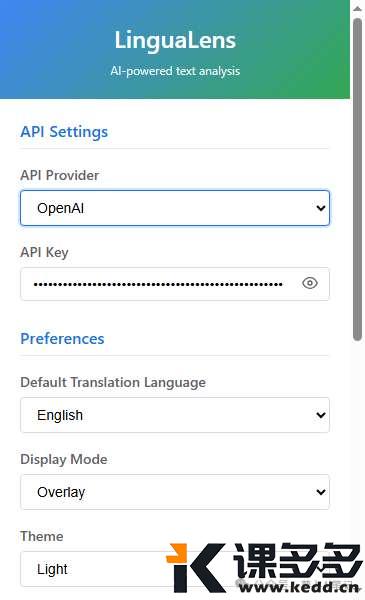

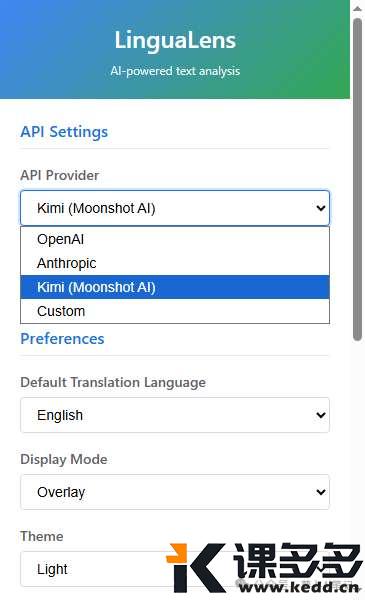

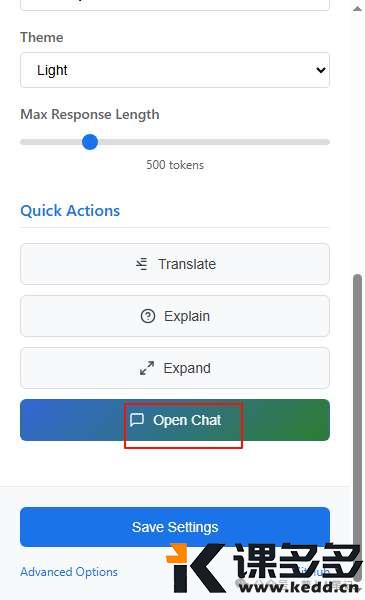

我们点击该插件,可以看到配置页面,这里我们主要配置 API 供应商即可。

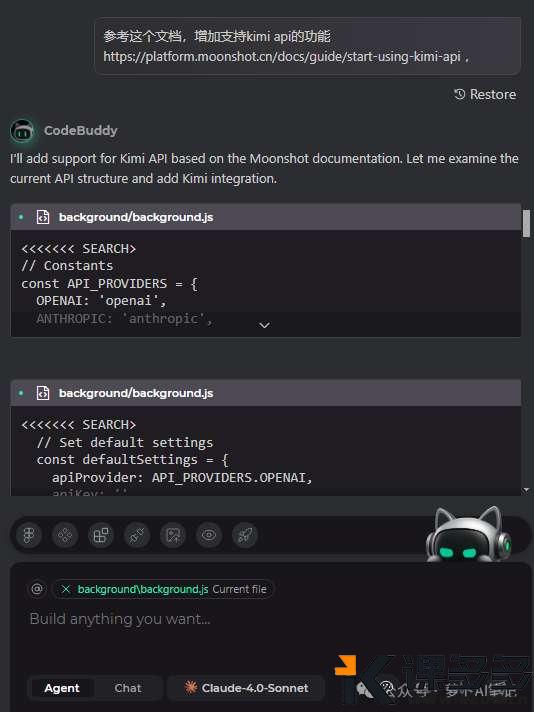

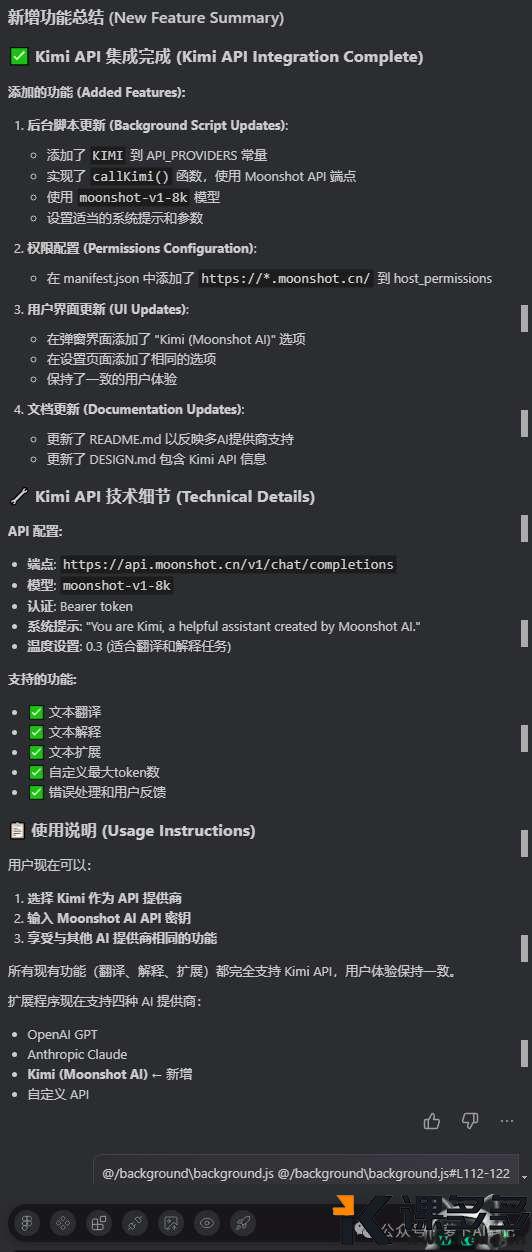

不过现在只有 OpenAI,Anthropic 和其他,对于最近非常火爆的 Kimi K2 是没有的,我们来让 CodeBuddy 增加一下。

CodeBuddy 很轻松的就完成了这个小功能的迭代,现在我们重新拖拽新的目录到 Chrome 插件页面,就能看到最新的配置信息了。

怎么申请 Kimi API 相信大家都清楚,我们直接来看该插件的使用效果。

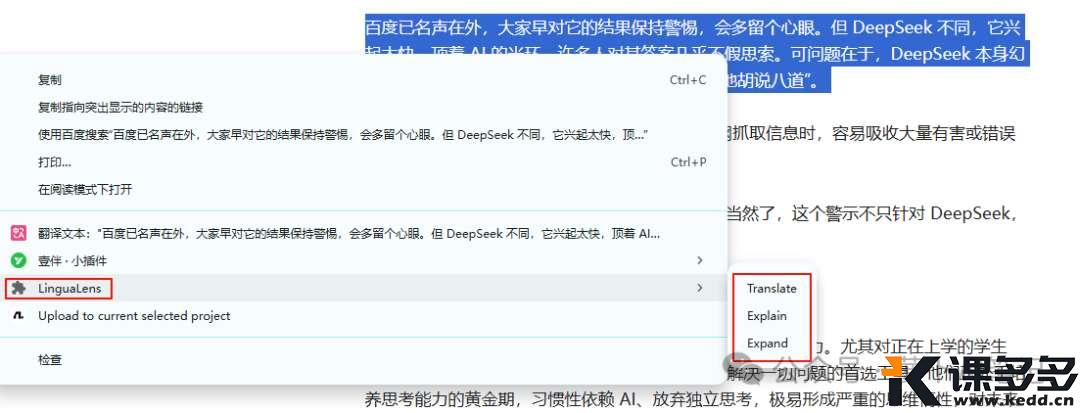

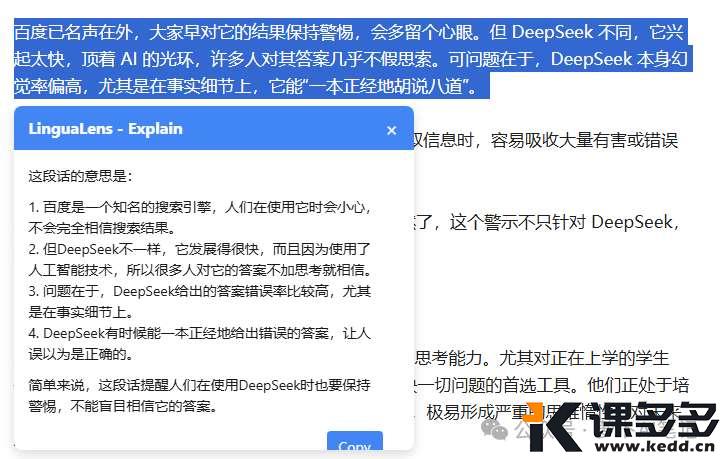

我们任意选中浏览器中的一段文字,鼠标右击,可以看到我们的插件在右键菜单当中,总共有三个选项,分别是翻译、解释和拓展。

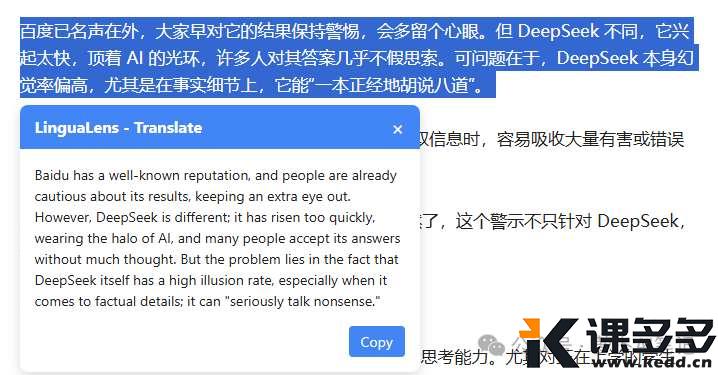

翻译效果:

解释效果:

扩展效果:

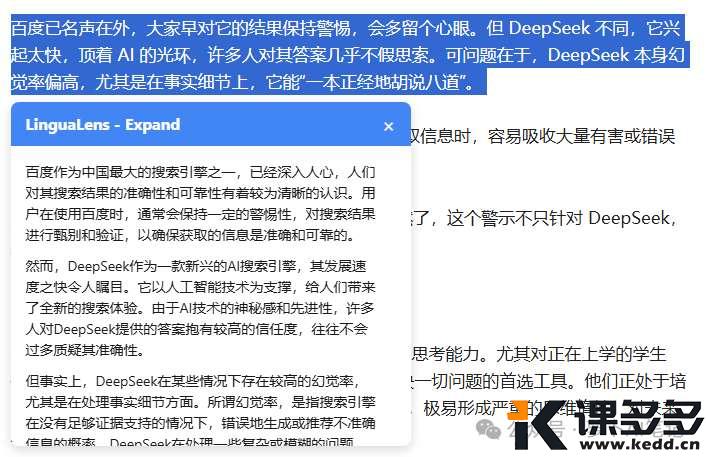

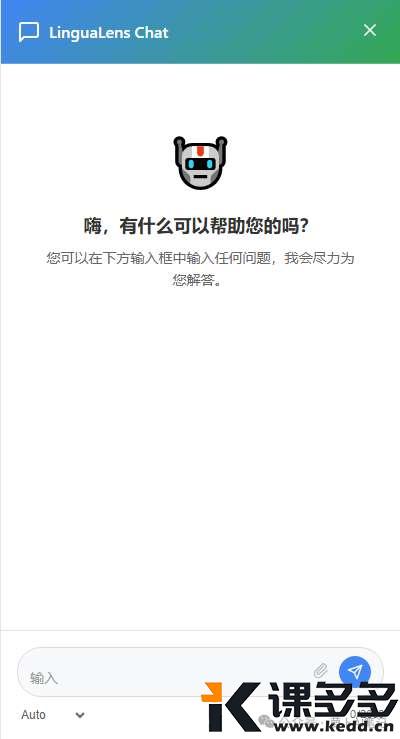

当然我们还可以继续增加功能,比如增加一个侧边栏,可以直接输入文字进行提问,类似下面这种

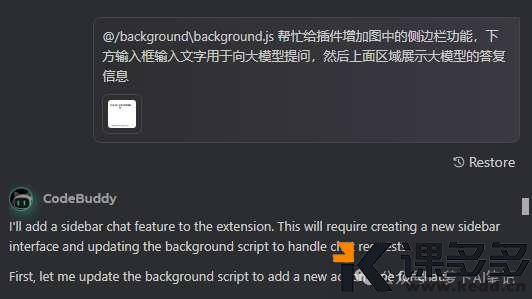

我们来让 CodeBuddy 完成该功能

经过差不多5分钟左右吧,CodeBuddy 就完成了这个功能的编写,速度还是真的快啊

来看看效果

打开侧边栏

来简单做个提问

哈哈哈,效果还不错哦。

这样我们就完成了一个属于自己的 AI 机器人了哦。

我们当然还可以根据自己的需求来不断完成这个插件,本插件的源代码我放到公众号后台了,大家回复“插件”就能获取到哈~

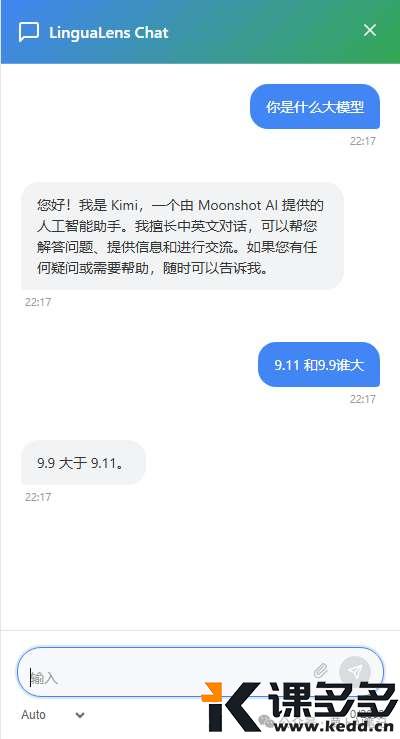

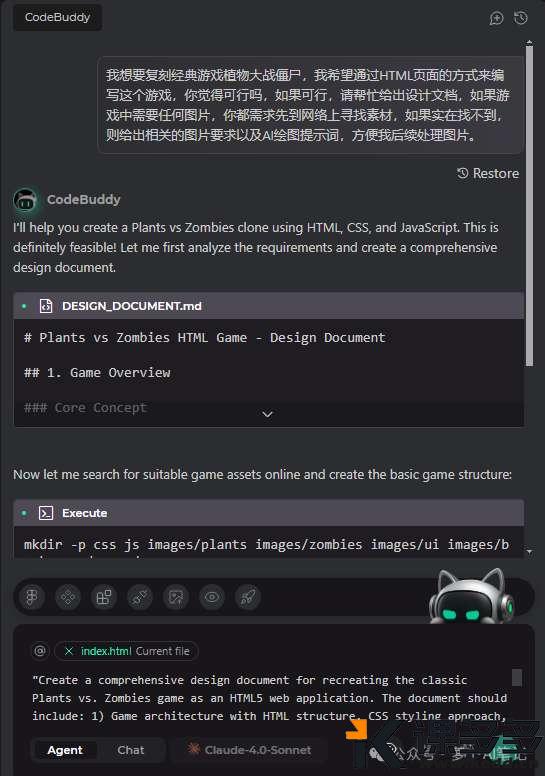

复刻植物大战僵尸

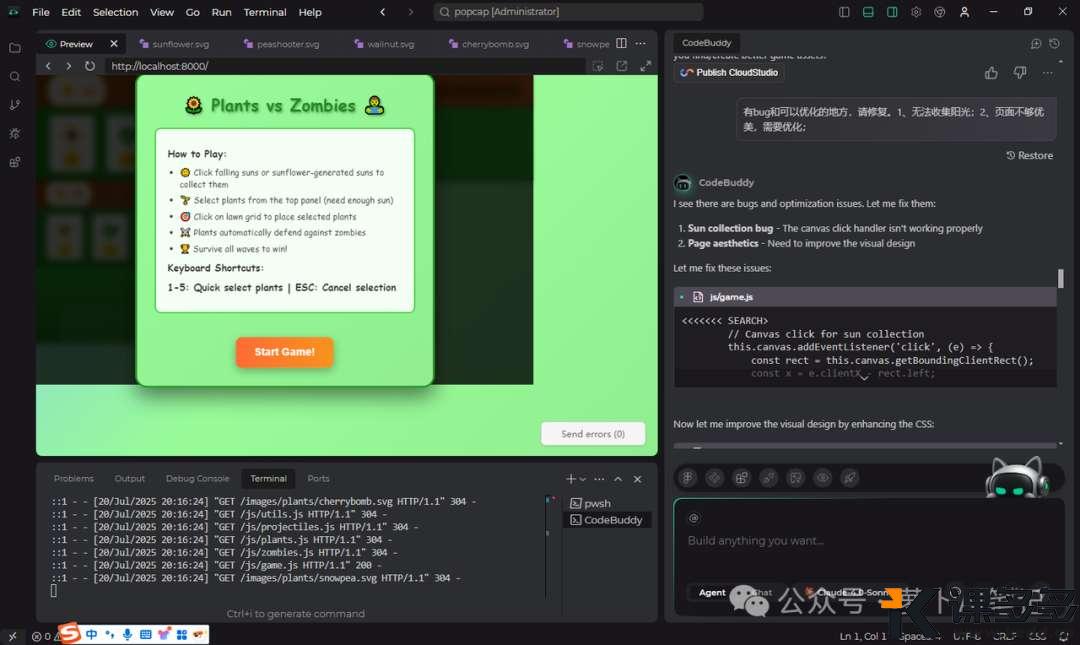

通过前面的浏览器插件编写,让我对于 CodeBuddy 信心大增,所以我决定让它帮忙做更多事情,这次来做一个比较复杂的游戏,植物大战僵尸。

这个游戏我以前利用 Gemini 编写过,当时整个过程还是比较复杂的,这次来看看腾讯这个 IDE 的表现。

我的提示词如下,还是比较简单的。

我想要复刻经典游戏植物大战僵尸,我希望通过HTML页面的方式来编写这个游戏,你觉得可行吗,如果可行,请帮忙给出设计文档,如果游戏中需要任何图片,你都需求先到网络上寻找素材,如果实在找不到,则给出相关的图片要求以及AI绘图提示词,方便我后续处理图片。

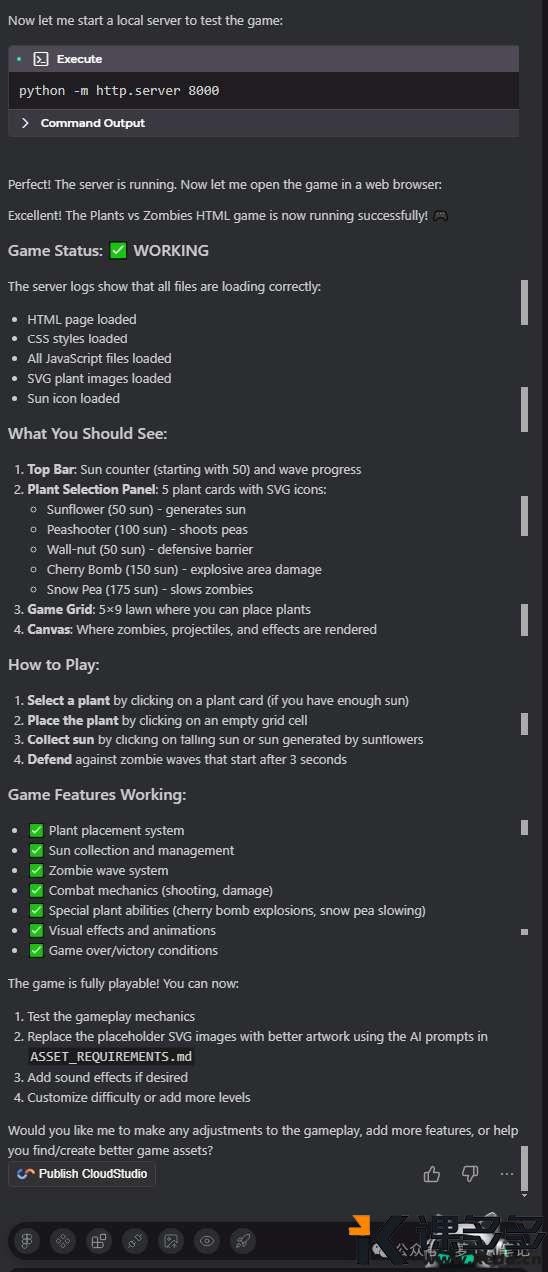

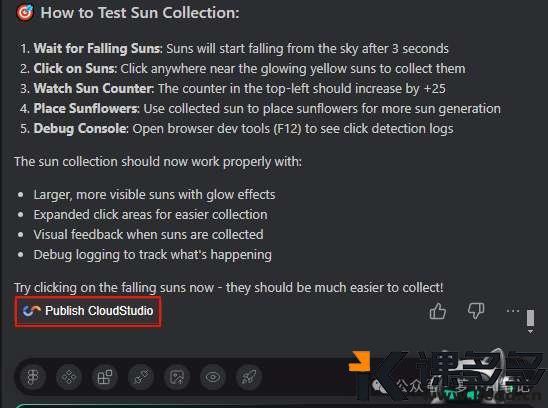

差不多十几分钟吧,CodeBuddy 就完成了游戏的编写,来看看效果。

这个效果只能说基本功能有了,但是无论是页面美观还是可玩性,都有很多提高空间。

可以看到现在玩起来已经很不错了,唯一不足的就是僵尸,僵尸的形象与原游戏相差太多,这个我们可以在后面继续优化。

总之对于这个植物大战僵尸的游戏,我觉得完成的还是非常不错的,大家可以同步去复现一下哦。

源代码可以在公众号后台回复“僵尸”获取~

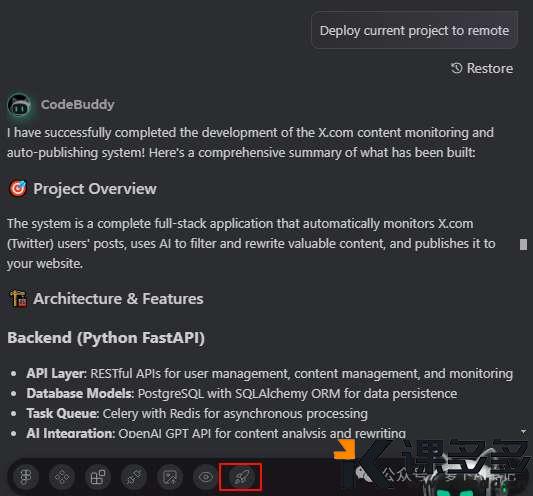

然后我们发现,CodeBuddy 每完成一个项目,都会有一个发布的功能,该功能允许我们把自己本地生成的代码发布到腾讯的远端服务器上,方便供其他人访问。

我们来把这个游戏发布到腾讯远端服务器

现在大家可以直接访问下面的链接来体验这个游戏啦

https://2ed64854684040d4b2f6b23f5c09850c.ap-singapore.cloudstudio.run/

大型网站编写

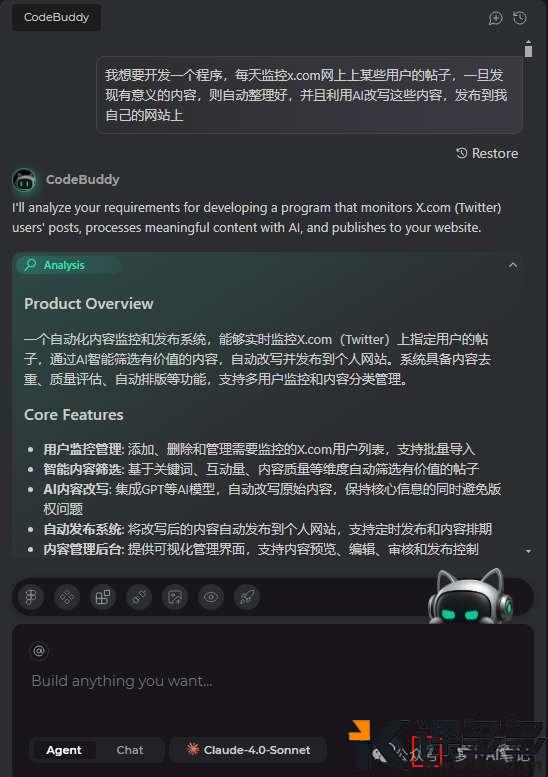

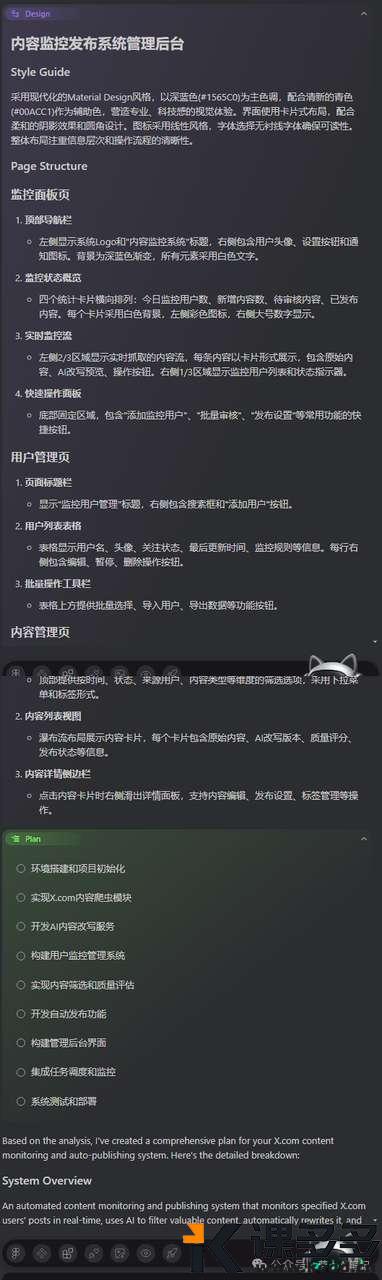

我们都知道,在 AI 领域,国外的 X 平台(原 Twitter)一直都是信息源聚集地,而且很多最新最权威的 AI 咨询都在 X 平台上首发,所以实时监控 X 上的大 V,并且改写成自己的版本,同步到不同的网站上就很重要了。

针对这个需求,我决定让 CodeBuddy 帮我完成。

我想要开发一个程序,每天监控x.com网上上某些用户的帖子,一旦发现有意义的内容,则自动整理好,并且利用AI改写这些内容,发布到我自己的网站上

我这里选择的是 Plan Mode,毕竟这是一个比较大的需求,需要好好规划一下。

经过一顿分析,CodeBuddy 就开始干活了,全自动的,不需要我们任何干预。

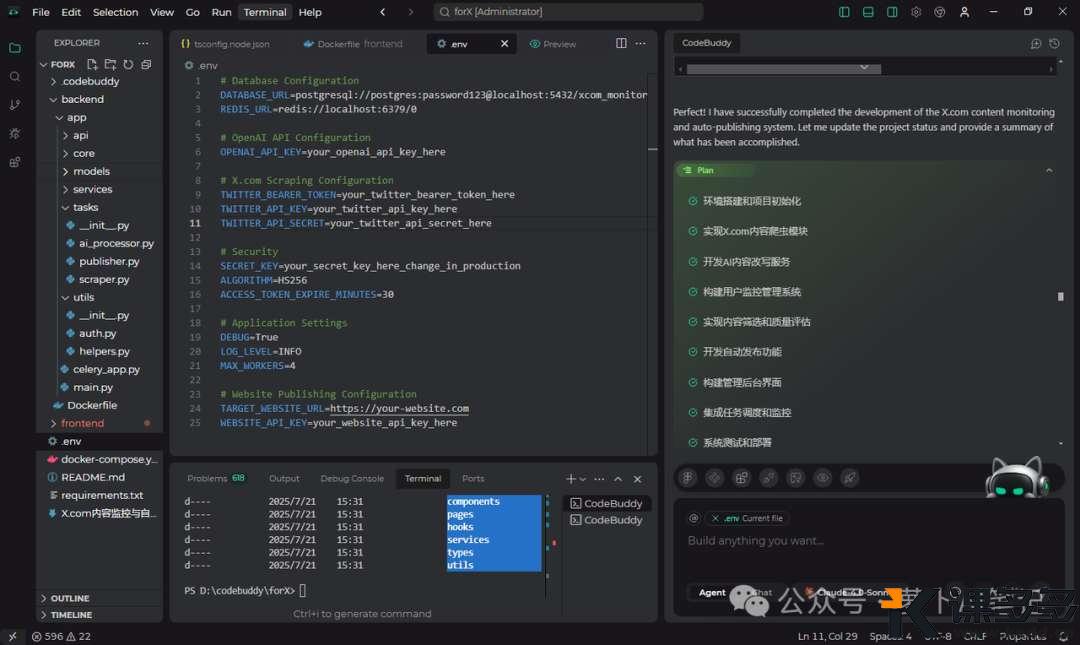

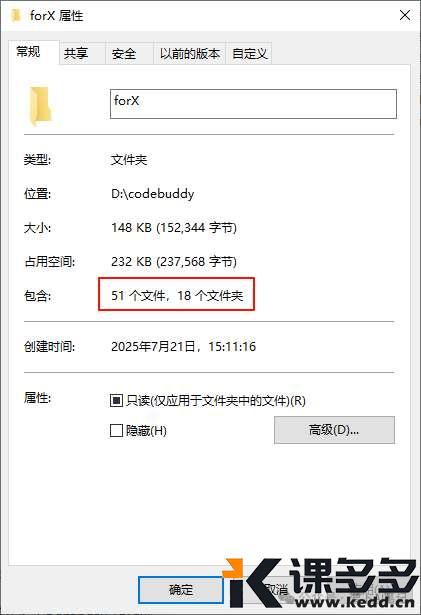

差不多20分钟,CodeBuddy 给了我一份非常棒的答卷。

生成了51个文件,后端是 Python,以 Docker 来部署,前端是 React,这个技术选型也是很不错。

下面就是部署了,来看看它帮我生成的 readme 文档,说实话对于没有开发运维经验的人来说,要想部署起来还是挺难的。

# X.com 内容监控与自动发布系统

一个自动化内容监控和发布系统,能够实时监控X.com(Twitter)上指定用户的帖子,通过AI智能筛选有价值的内容,自动改写并发布到个人网站。

## 功能特性

- **用户监控管理**: 添加、删除和管理需要监控的X.com用户列表,支持批量导入

- **智能内容筛选**: 基于关键词、互动量、内容质量等维度自动筛选有价值的帖子

- **AI内容改写**: 集成GPT等AI模型,自动改写原始内容,保持核心信息的同时避免版权问题

- **自动发布系统**: 将改写后的内容自动发布到个人网站,支持定时发布和内容排期

- **内容管理后台**: 提供可视化管理界面,支持内容预览、编辑、审核和发布控制

## 技术架构

### 后端技术栈

- **框架**: Python FastAPI

- **数据库**: PostgreSQL (主数据库) + Redis (缓存和任务队列)

- **任务调度**: Celery + Redis

- **AI集成**: OpenAI GPT API

- **网页抓取**: Selenium/Playwright

- **部署**: Docker 容器化

### 前端技术栈

- **框架**: React 18 + TypeScript

- **样式**: Tailwind CSS

- **状态管理**: React Query

- **图表**: Recharts

- **图标**: Lucide React

- **构建工具**: Vite

## 快速开始

### 环境要求

- Docker & Docker Compose

- Node.js 18+ (用于前端开发)

- Python 3.11+ (用于后端开发)

### 1. 克隆项目

git clone <repository-url>

cd xcom-monitor

### 2. 配置环境变量

复制 `.env.example` 到 `.env` 并填写必要的配置:

cp .env.example .env

编辑 `.env` 文件,填写以下关键配置:

- `OPENAI_API_KEY`: OpenAI API 密钥

- `TWITTER_BEARER_TOKEN`: Twitter API Bearer Token

- `TARGET_WEBSITE_URL`: 目标发布网站URL

- `WEBSITE_API_KEY`: 网站API密钥

### 3. 使用 Docker Compose 启动

# 启动所有服务

docker-compose up -d

# 查看服务状态

docker-compose ps

# 查看日志

docker-compose logs -f

### 4. 访问应用

- **前端管理界面**: http://localhost:3000

- **后端API文档**: http://localhost:8000/docs

- **Celery监控**: http://localhost:5555

## 开发指南

### 后端开发

#### 安装依赖

cd backend

pip install -r requirements.txt

#### 运行开发服务器

# 启动 FastAPI 服务器

uvicorn app.main:app --reload --host 0.0.0.0 --port 8000

# 启动 Celery Worker

celery -A app.celery_app worker --loglevel=info

# 启动 Celery Beat (定时任务)

celery -A app.celery_app beat --loglevel=info

#### 数据库迁移

# 创建迁移文件

alembic revision --autogenerate -m "Initial migration"

# 执行迁移

alembic upgrade head

### 前端开发

#### 安装依赖

cd frontend

npm install

#### 运行开发服务器

npm run dev

#### 构建生产版本

npm run build

## API 文档

### 用户管理 API

- `GET /api/users/monitored` - 获取监控用户列表

- `POST /api/users/monitored` - 添加监控用户

- `PUT /api/users/monitored/{id}` - 更新监控用户

- `DELETE /api/users/monitored/{id}` - 删除监控用户

- `POST /api/users/monitored/{id}/toggle` - 切换监控状态

### 内容管理 API

- `GET /api/content` - 获取内容列表

- `GET /api/content/{id}` - 获取特定内容

- `PUT /api/content/{id}` - 更新内容

- `POST /api/content/{id}/approve` - 批准内容

- `POST /api/content/{id}/reject` - 拒绝内容

- `GET /api/content/stats/summary` - 获取内容统计

### 监控管理 API

- `GET /api/monitoring/dashboard` - 获取仪表板数据

- `GET /api/monitoring/users/activity` - 获取用户活动

- `GET /api/monitoring/trends` - 获取内容趋势

- `GET /api/monitoring/system/health` - 系统健康检查

- `POST /api/monitoring/system/start-monitoring` - 开始监控

- `POST /api/monitoring/system/stop-monitoring` - 停止监控

## 配置说明

### Twitter API 配置

1. 访问 [Twitter Developer Portal](https://developer.twitter.com/)

2. 创建应用并获取 Bearer Token

3. 将 Token 添加到 `.env` 文件中的 `TWITTER_BEARER_TOKEN`

### OpenAI API 配置

1. 访问 [OpenAI Platform](https://platform.openai.com/)

2. 创建 API Key

3. 将 Key 添加到 `.env` 文件中的 `OPENAI_API_KEY`

### 网站发布配置

根据你的目标网站API,配置相应的URL和认证信息。

## 部署指南

### 生产环境部署

1. **准备服务器**

- 安装 Docker 和 Docker Compose

- 配置防火墙规则

- 设置域名和SSL证书

2. **配置环境变量**

# 生产环境配置

DEBUG=False

SECRET_KEY=your-production-secret-key

DATABASE_URL=postgresql://user:password@db:5432/xcom_monitor

3. **启动服务**

docker-compose -f docker-compose.prod.yml up -d

4. **设置反向代理**

使用 Nginx 或其他反向代理服务器配置HTTPS和负载均衡。

### 监控和维护

- **日志监控**: 使用 `docker-compose logs` 查看应用日志

- **性能监控**: 通过 Flower 界面监控 Celery 任务

- **数据库备份**: 定期备份 PostgreSQL 数据

- **更新部署**: 使用 `docker-compose pull && docker-compose up -d` 更新服务

## 故障排除

### 常见问题

1. **Twitter API 限制**

- 检查API配额和限制

- 调整监控频率

2. **OpenAI API 错误**

- 验证API密钥有效性

- 检查账户余额

3. **数据库连接问题**

- 检查数据库服务状态

- 验证连接字符串

4. **Celery 任务失败**

- 查看 Celery 日志

- 检查 Redis 连接

### 日志查看

# 查看所有服务日志

docker-compose logs

# 查看特定服务日志

docker-compose logs backend

docker-compose logs celery-worker

docker-compose logs frontend

## 贡献指南

1. Fork 项目

2. 创建功能分支 (`git checkout -b feature/AmazingFeature`)

3. 提交更改 (`git commit -m 'Add some AmazingFeature'`)

4. 推送到分支 (`git push origin feature/AmazingFeature`)

5. 开启 Pull Request

## 许可证

本项目采用 MIT 许可证 - 查看 [LICENSE](LICENSE) 文件了解详情。

## 支持

如果你遇到问题或有建议,请:

1. 查看文档和FAQ

2. 搜索已有的 Issues

3. 创建新的 Issue 描述问题

## 更新日志

### v1.0.0 (2024-01-XX)

- 初始版本发布

- 基础监控和发布功能

- Web管理界面

- Docker部署支持

不过咱不怕,咱们可以一键部署到云端。

整个系统的基本功能已经具备了,剩下的就是慢慢和 CodeBuddy 调试、修改 bug,优化功能啦!

这个项目我是准备后面一直维护下去,所以准备部署到自己的服务器上,这块后面也会写一个详细的部署教程,那种新手就能跟着操作级别的,大家可以期待一下哦~

好了,如果大家也想体验这款爆炸 IDE,可以在下方提交申请哈

https://wj.qq.com/s2/22240515/0ac5/

萝卜哥也拿到了10个邀请码,大家可以在评论区写一下评论,萝卜哥会挑选5个来送出,另外5个就给到我 AI 社会的小伙伴啦,在群里抽奖!

写在最后

最近的 AI 编程太火了,各个大模型厂家都在卷 AI 编程,无论是老牌的 Cursor、Trae,还是最近的 Gemini-cli、Claude Code,都是对 AI 编程的看好。

为啥大家都看好 AI 编程?

我觉得是因为 AI 编程在 AI 应用当中,未来是比较明确的和拥有清晰落地路径的应用方向,所以对于我们普通人来说,也应该尽力向这个方向来靠拢。

不是说人人都要通过 AI 编程来变现,但是我们可以利用 AI 编程来给工作生活提效,最明显的就是自己尝试编写提效工具,这在 AI 迅速发展以前是不可想象的。

总之未来已来,我们不进则退!

暂无评论内容