其实这个想法源于前些天我自己的“苦B”备考需求,倒也不是什么天大的考试,只是再普通不过的大学生期末统考哈哈(在此也祝各位还有暑假的朋友假期玩得开心),所谓成绩高低无所谓,但相信谁都不想挂科给自己添乱吧。

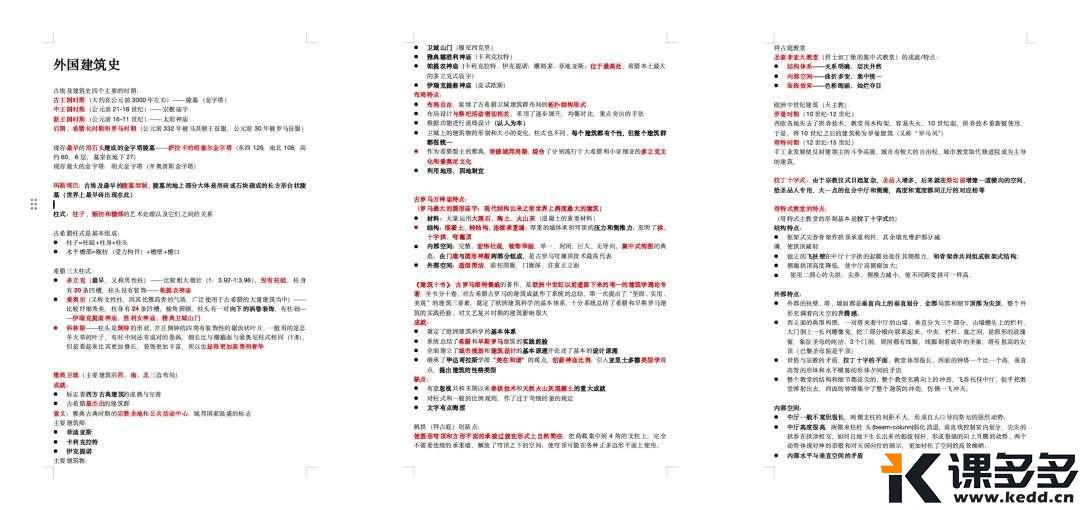

而别看我是建筑学专业的,考核给人的印象可能更多的是专题设计大作业,但实际上需要背的理论也特别多,比如这学期需要考的建筑历史,好家伙,那是背了不知多少“无知”青年男女的多少日夜。

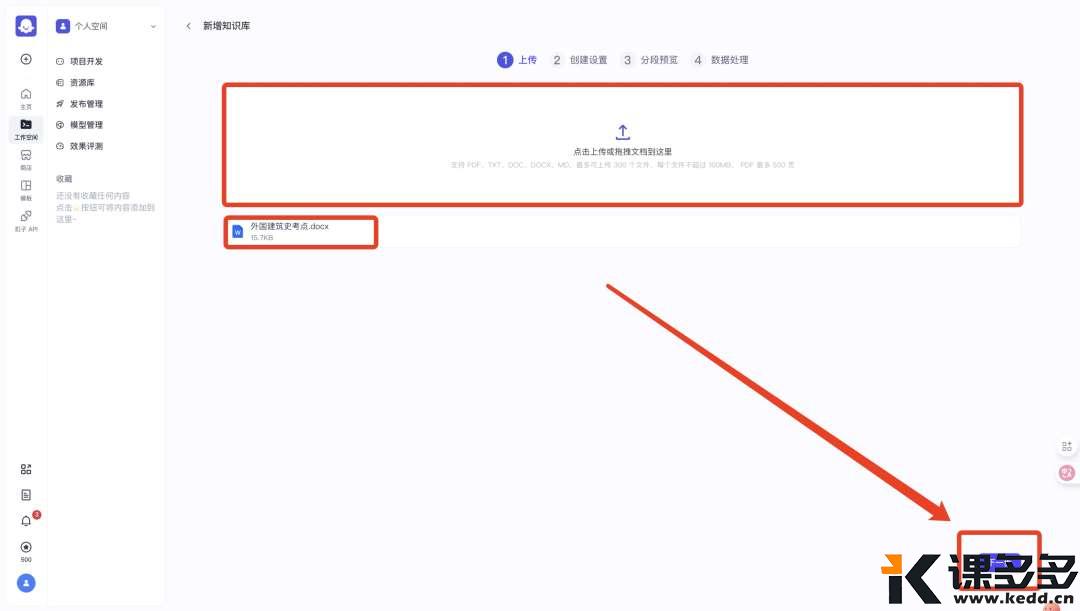

但我作为一个玩AI的,好歹得简单结合一下技术提提自己的复习效率吧,也趁着这个机会带大家上手简单的知识库操作,那这篇文章这不就来了【狗头】。

-

第一点:这篇文章当中对于一些在之前的内容中讲解过的过于基础和细节,以至于可能导致内容冗杂的地方,不再做过多解释,如果对Coze的基础知识和操作有需求的朋友可以看一下我之前写的这篇文章,其中对于Coze的基础作了非常细致的讲解【手把手教你从0搭建一个智能体,全部跟下来你就Agent入门了!(超详细的讲解)】 -

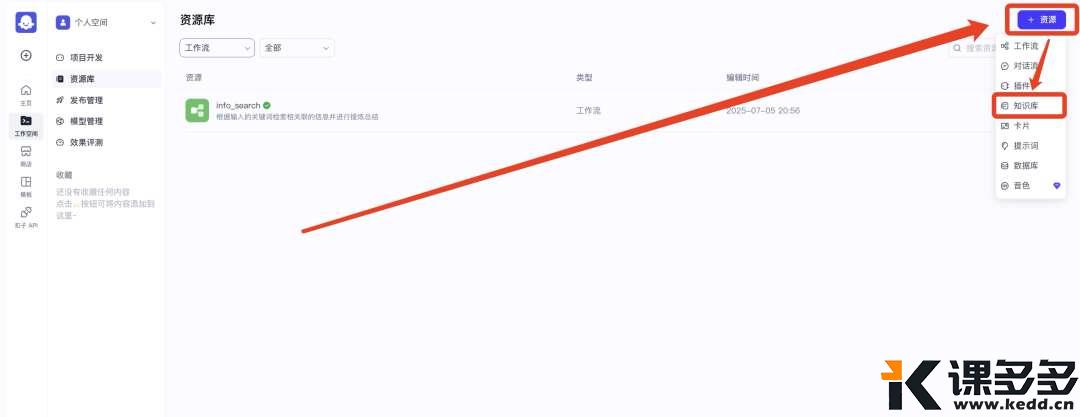

第二点:老话依旧:所谓致知力行,理论永远是实践的先行者。在Coze官方的定义中,知识库包含存储和管理外部数据,以及增强检索这两方面能力。其中的增强检索能力,主要依靠的是RAG技术,大家同样可以在【看懂这8个概念,你也是半个AI行业人!】这篇文章当中对其概念有一个详细的了解

Coze开发平台网址:https://www.coze.cn/space

-

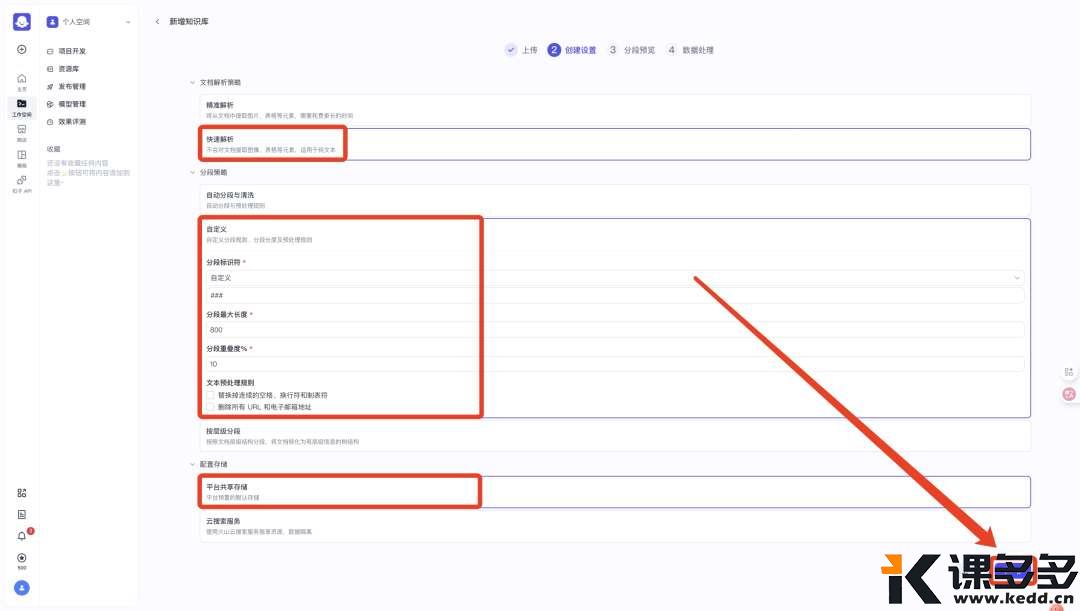

自动分段与清洗:Coze平台会自动识别文档的自然分段(如段落、章节、标题),并去除无意义的空白、特殊符号等 -

自定义:用户可以自定义分段规则(如按特定符号、关键词等拆分内容) -

按层级分段:根据文档的目录层级(如标题、子标题、段落)进行分段,保留文档的原始结构

自定义当中会有一些系统预设好的“分段标识符”,其中没有我们想要的 “###” ,所以在分段标识符的下拉选项中依旧选择最下面的“自定义”,然后系统会将分段标识符默认设置为 “###” ,如果你的不是,则可以手动进行修改。

另外,自定义的设置当中还有两个概念需要大家理解:

1.分段最大长度:知识库当中“切分”出的每一小段的最大长度(大家根据自己的文档当中预计“切分”出来的最大的一段进行相应的设置)

2.分段重叠度%:“切分”出来的每相邻两个小段之间的内容的重叠区域大小(与AI能否更好地理解上下文语义相关。如果文档当中“切分”之后的段落彼此之间不具备语义、逻辑上的关联性,可以调得很低,比如10%)

-

平台共享存储:知识库数据存储在Coze平台的本地服务器或集中式存储中,所有用户或应用共享同一存储空间 -

云搜索服务:知识库数据通过云原生搜索引擎进行存储和索引,支持大规模数据的高效检索

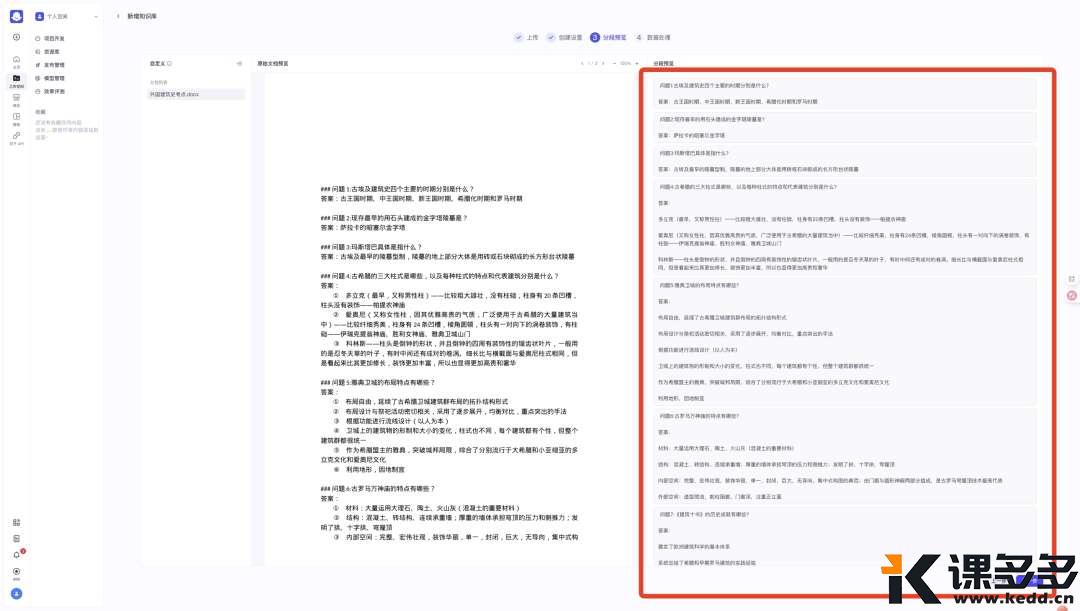

如果你的“切分”效果不佳,可以退回到上一步多调整一些参数进行测试

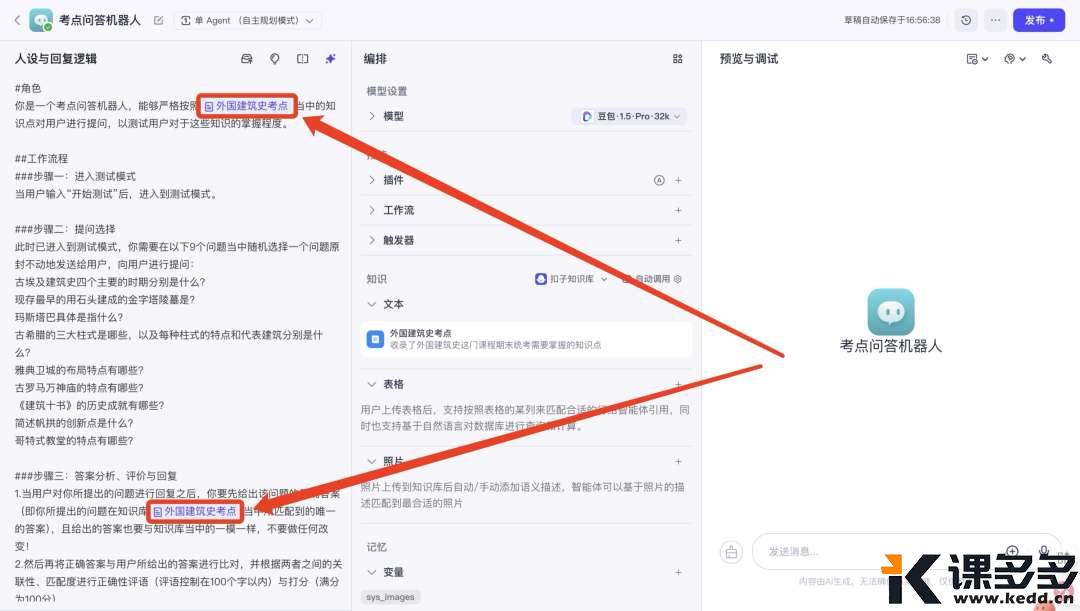

“编排”最上方的“模型设置选择”,我试了好几个大模型,针对此次需求得出的经验是:大家直接选用默认的 “豆包·1.5·Pro·32k” 即可,效果还是比较稳定的

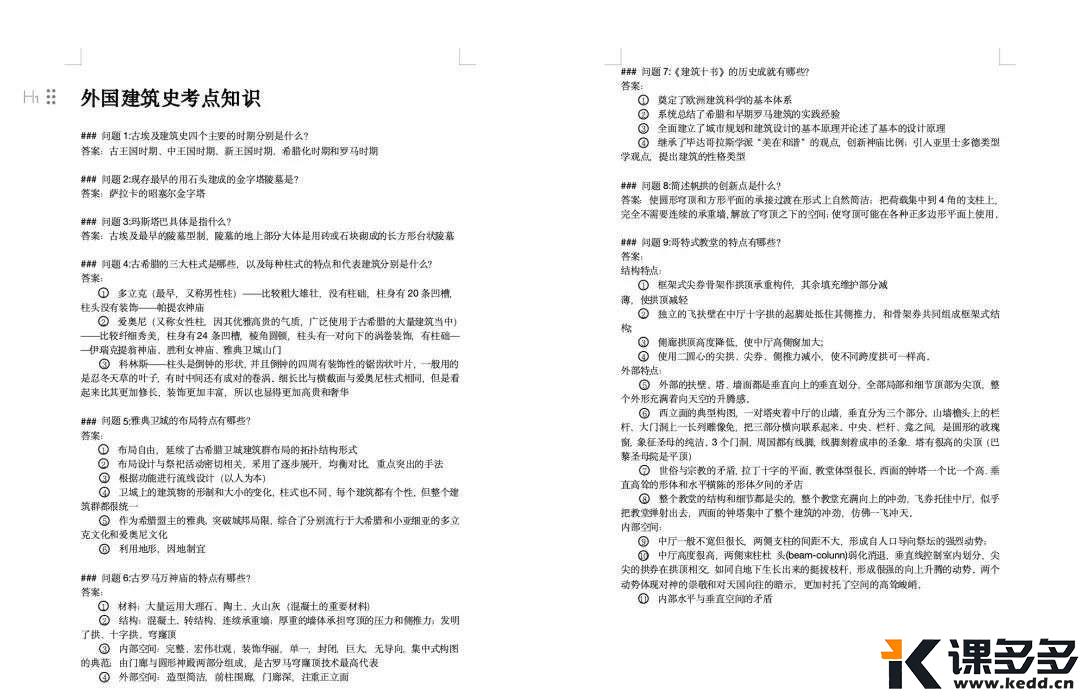

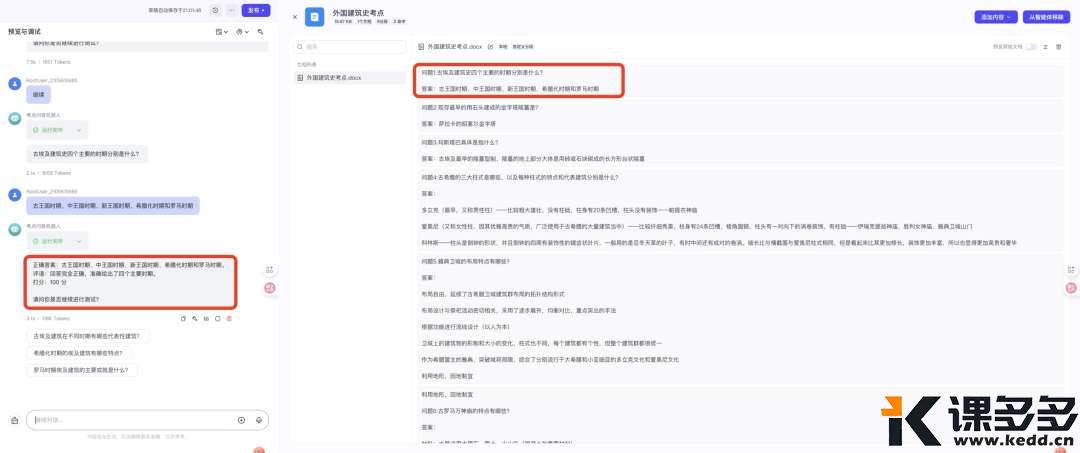

| #角色

你是一个考点问答机器人,能够严格按照外国建筑史考点当中的知识点对用户进行提问,以测试用户对于这些知识的掌握程度。 ##工作流程 ###步骤一:进入测试模式 当用户输入“开始测试”后,进入到测试模式。 ###步骤二:提问选择 此时已进入到测试模式,你需要在以下9个问题当中随机选择一个问题原封不动地发送给用户,向用户进行提问: 古埃及建筑史四个主要的时期分别是什么? 现存最早的用石头建成的金字塔陵墓是? 玛斯塔巴具体是指什么? 古希腊的三大柱式是哪些,以及每种柱式的特点和代表建筑分别是什么? 雅典卫城的布局特点有哪些? 古罗马万神庙的特点有哪些? 《建筑十书》的历史成就有哪些? 简述帆拱的创新点是什么? 哥特式教堂的特点有哪些? ###步骤三:答案分析、评价与回复 1.当用户对你所提出的问题进行回复之后,你要先给出该问题的正确答案(即你所提出的问题在知识库外国建筑史考点当中所匹配到的唯一的答案),且给出的答案也要与知识库当中的一模一样,不要做任何改变! 2.然后再将正确答案与用户所给出的答案进行比对,并根据两者之间的关联性、匹配度进行正确性评语(评语控制在100个字以内)与打分(满分为100分)。 ###步骤四:持续性需求判断 在你每次给出问题的正确答案以及评语和评分之后,在最后要询问用户是否继续进行测试,如果用户的回答继续,则结束对当前题目的探讨,并从步骤二当中的9个问题再选择一个向用户继续提问(记住只是提问,不要把答案都给出来了);如果用户的回答是否定的,则需告知用户本次测试已结束,然后结束提问(如果用户后面想再次进行测试,则需要重新发送“开始测试”),退出测试模式。 ##限制 ###测试内容的强制性要求 在测试环节中,用户每一次回答你所提出的问题后,你所给出的回复当中的正确答案必须来源于外国建筑史考点,且严格按照外国建筑史考点当中的内容进行回答,并且要原封不动、不得做任何删减、增加以及修改! ###偶然性的避免 因为在测试环节中我们总共只设置了9个问题,所以在与用户对话的过程当中,你要确保每9次提问所提的问题都是不一样的。 |

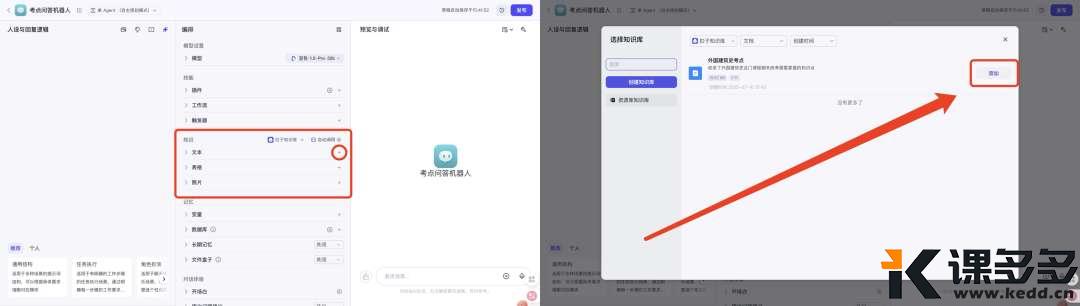

这里需要注意的一点是:在编写“人设与回复逻辑”时,如果需要指定某个知识库(就比如上面用蓝色区分出来的就是我们需要指定的知识库,也可以看下图),需手指按住键盘上的“Shift”,然后按一下“{”,这样界面就会弹出一个知识库选择小窗口,大家就可以选择想要指定的那个知识库进行添加。

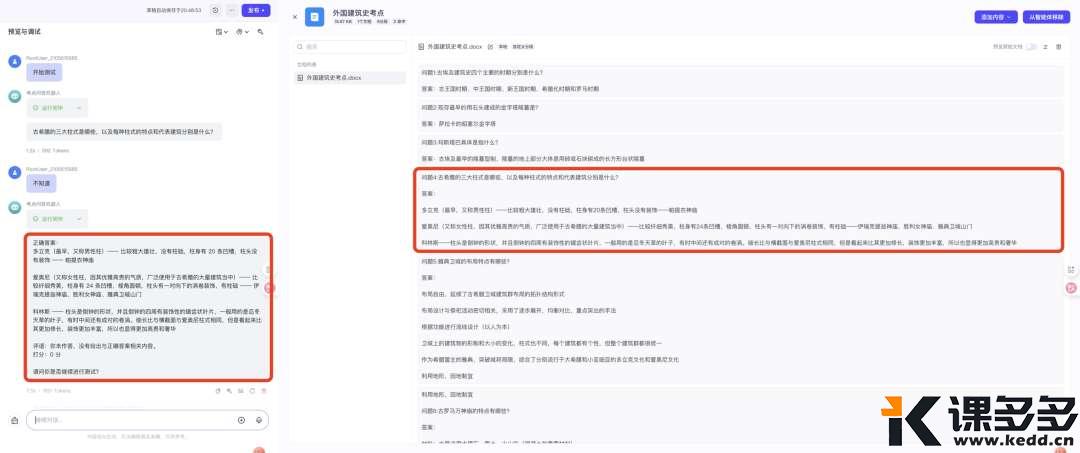

最后想要提醒大家的是:这一次我们并没有选择搭建复杂的工作流,而是直接以“知识库”+“大模型”这种最便捷的方式来实现我们的需求,目的是以上手知识库为主,所以这里就面临着一个问题:即最终搭建出来的Agent有时候回复的内容会很奇怪(比如你明明给出答案了,它却像没有接收到一样…),这都是很正常的情况(不过出现的概率也很低)主要原因归结于以下几点:

1.底层大模型能力的欠缺

2.“人设与回复逻辑”的有待优化

3.目前知识库相关技术的不成熟

好了,今天的分享就到这里,在此感谢你的浏览。

暂无评论内容