「即梦 x Midjourney」神级工作流

Midjourney (MJ) 是一个国外的 AI文生图模型,审美是最强的,名画都是线下3D扫描,在各大博物馆深入打标数据。而他的弊端在于很少收录中国文化的东西,以及对英语很依赖,并且对视听的理解不高。

接下来会告诉你怎么用 即梦 + MJ 精准地出分镜图。

前期 Q&A

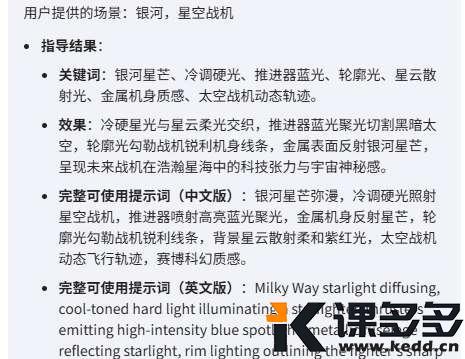

Q:我们为什么要用「即梦 + MJ」?

A: 原因在于,MJ 的 提示词 中支持的范围远远大于其他的 AI,他可以精准到控制用什么相机、用什么胶片、用什么质感、用什么光影比例,模仿哪一部电影里哪个导演的风格。

但这也导致了他的 随机性 比其他AI更强,更 难以操控。这就需要一张 底图 来提高我们的 控制范围,而代价是 图片质量 会下降。即便图片质量下降,饿死的骆驼依然比马大。

拿对比说话

使用相同的 提示词,拿出两组对照图。

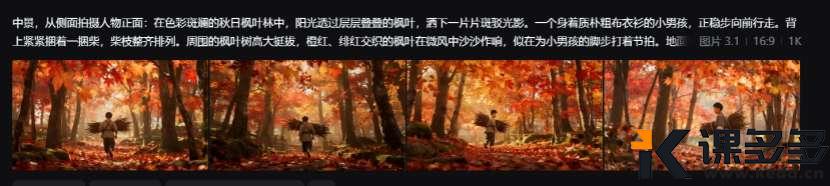

提示词:

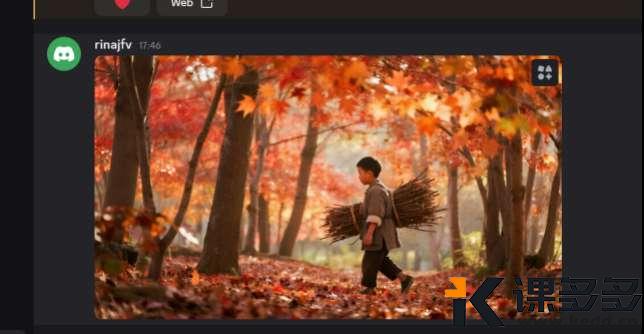

中景,从侧面拍摄人物正面:在色彩斑斓的秋日枫叶林中,阳光透过层层叠叠的枫叶,洒下一片片斑驳光影。一个身着质朴粗布衣衫的小男孩,正稳步向前行走。背上紧紧捆着一捆柴,柴枝整齐排列。周围的枫叶树高大挺拔,橙红、绯红交织的枫叶在微风中沙沙作响,似在为小男孩的脚步打着节拍。地面铺满厚厚的枫叶,形成一张柔软且色彩绚丽的地毯。

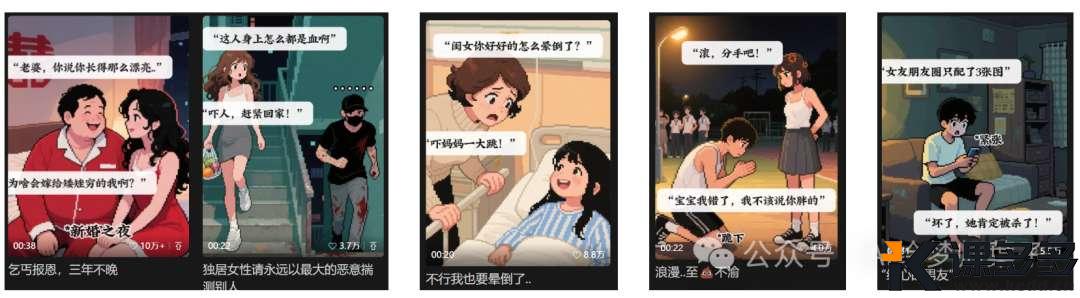

第一组:即梦直接出图

可以看到,即梦 出的图是非常接近的,并且风格很保守。但是问题在于 质感太差,很明显的塑料感觉,一眼给人很假的感觉,完全没有 电影感。

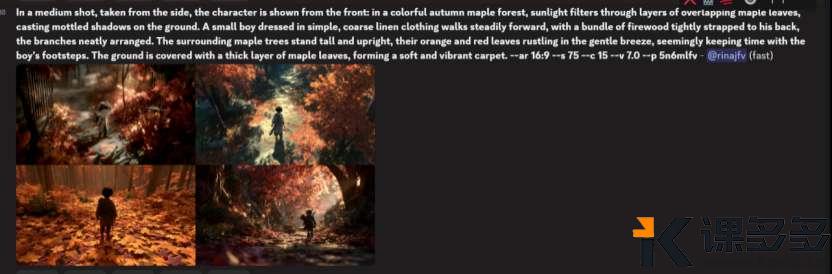

第二组:MJ 直接生成

我们可以看到,MJ 出的图很明显比 即梦 出的 质感更好,但问题在于 不可控。即便画面内容相同,但输出的画面也大有不同。

如何让MJ的画面更 统一?这就需要我们把 即梦 和 MJ 做结合!下面看教程。

手把手教程:即梦 + Midjourney 强强联合

第一步: 在即梦里出图

在即梦里出图的目的是为后续出图打基础(AI 圈内叫做 底图),先在 即梦 里出一个大方向正确的图片。

案例:

我们先在即梦中生成一张基础图片。

底图 完成后下载到本地。

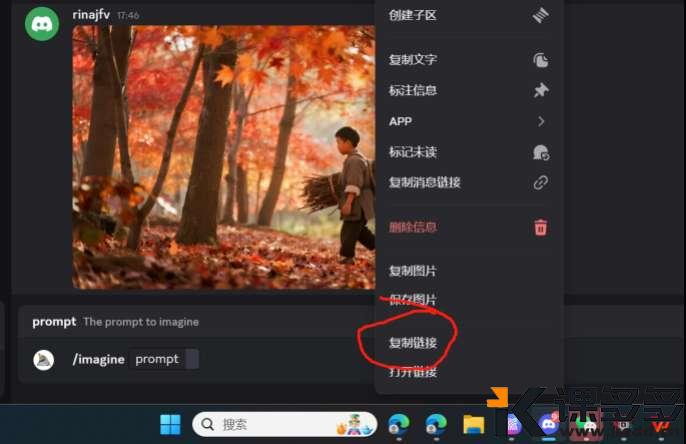

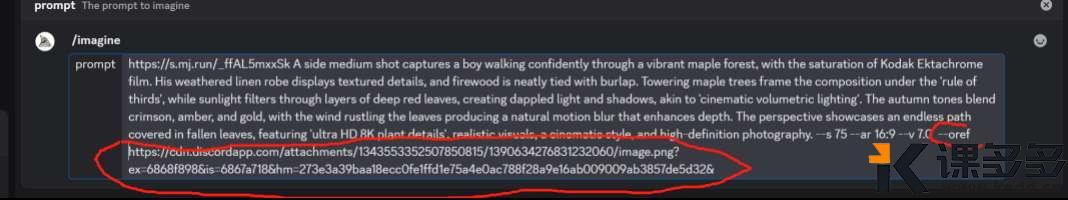

第二步:在MJ中垫图

-

1. 把 即梦 做好的图片放到聊天框中(如果是下载务必确保没有水印!如果清晰地够高截图也可以)。

-

2. 复制该图片的 引用网址。

-

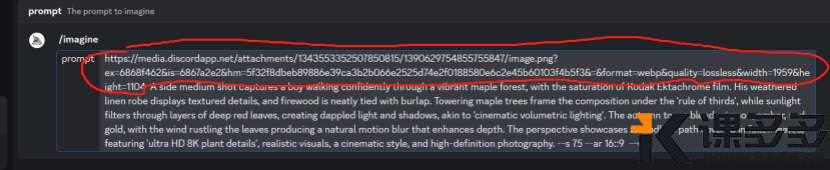

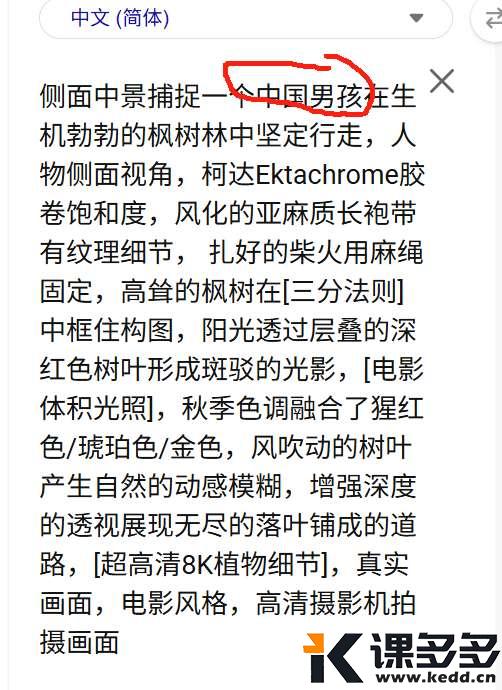

3. 把网址放在 提示词 的前方(ps,画幅比例多了个冒号,其实一个冒号就行)。

-

4. 得出结果。

可以很明显看到,这张 MJ 垫图后生成的图,质感 比起 即梦 的好上N倍。

那么有个新的问题:为什么中国男孩变成了欧美男孩?

答:正如开头所说,MJ 是老外的AI,他们默认是白人,其次黑人,最后黄种人,亚洲的文化也偏少,所以需要我们用 提示词介入(比如提示词:Asian man, Chinese boy 等)。当人物涉及到 一致性 的时候,需要介入下一个功能:--oref。

解决人物一致性:oref 功能详解

Q:什么是 oref?

A: --oref 是MJ V7新一代 一致性模型功能,上传一个人物图片,即可 控制物品或者人物一致性。但并不能完全一模一样,只能到80%。如果脸部严重不符,这时需要介入 ComfyUI 的 面部迁移功能(这是后话,不在本次课程中)。

使用方法如下:

1. 第一步,选择参考图

2. 第二步,引用参考图

-

• ① 人物在图片中运用多大就需要截取多大。

举例如下,还是这张图,我们的图片是一个全景的人物图,人物是可以看到全身的,所以这时候我们需要一个人物侧面的图作为 参考引用。

-

• ② 从三视图中,我们抽取这张图。

-

• ③ 复制这张图的链接。

-

• ④ 在我们刚刚的提示词下面输入 --oref+ 参考图的地址链接,同时在提示词中加入“中国男孩”。

我们可以发现,即便增加了控制变量,每一张图的人物也无法百分百还原。这时候我们需要抽上3-5次,最后选择一个接近想要的画面。

画面修复与最终出片

这时候有人就要问:我原图是侧面的,你这个是正面走的,完全不是我要的。

其实方法很简单,在跑视频的时候驱动即可,但在跑视频之前,我们需要对 脸部进行修复。可以看到,我们的小孩,脸部是糊的,这种图片是不合格的。

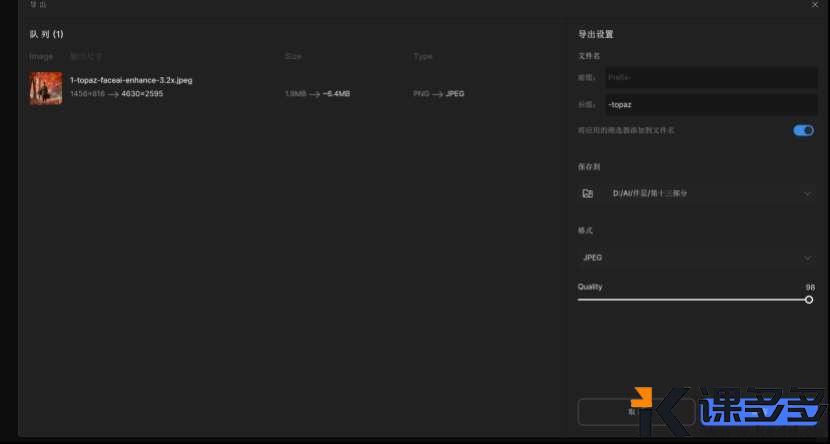

接下来则需要用到 Topaz Photo(需要 本地部署,资源在淘宝买,3块钱就有了,显卡最低要求3080+,如果没有找我后期修复)。

可以明显看到,人物的脸部被修复了。

导出注意要在10MB内。

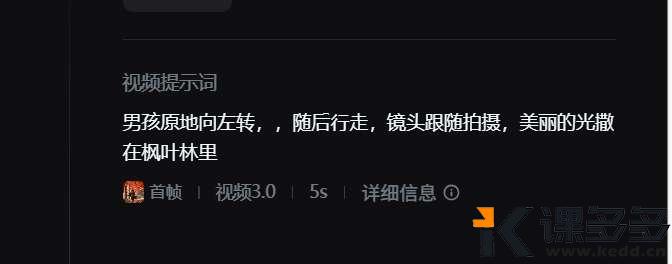

最后,导入 即梦,使用 视频推理 出侧面即可。

确定提示词和图片后刷3次,如果三次没有出到满意的则要考虑 调整提示词或者底图,5次没出就一定要调整。

总结

看完这个实操一遍,恭喜你学会怎么用 MJ 出一个 高质量分镜 啦!文章只是一种方法,实际还有多种方式(抽象法,多参法,多分镜推理法),还有 oref 和 iw 的 参数动态调整,这块就需要你们去多思考,AI出图效率 才会高!

暂无评论内容