最近的大模型圈子确实很热闹,一波接一波的更新应接不暇。

这边OpenAI的GPT4刚下线,接着就是o3和o4 mini同步上线。

o3和o4 mini属于推理模型。可以简单理解为类似于DeepSeek-R1。

![图片[1]-OpenAI放大招,豆包紧随其后,多模态推理时代到来-课多多](https://www.kedd.cn/wp-content/uploads/2025/05/1-77.jpg)

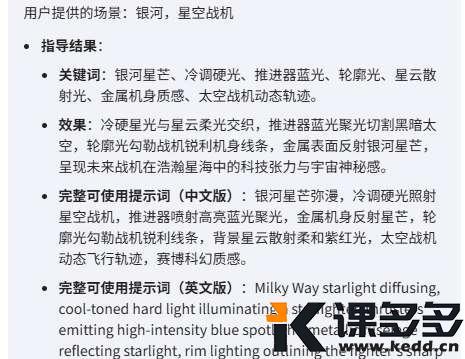

省流版功能解释:

1、能够调用ChatGPT里的各种工具

比如:网络搜索、Python、图像分析、文件解释和图像生成。

也就是你现在可以用o3完成GPT-4o的生图、改图操作。

2、可以把图像作为思维链的一环

就是可以基于图像进行思考。也就是你可以让o3帮助你分析你的图表,或者直接上传一份报告,让它基于图片中的内容做推理研究。

3、性价比提升

相比o1和o3-mini,o3和o4-mini更强,但却更经济!o3比o1便宜,o4‑mini跟o3-mini、o1-mini价格相同。

与此同时。

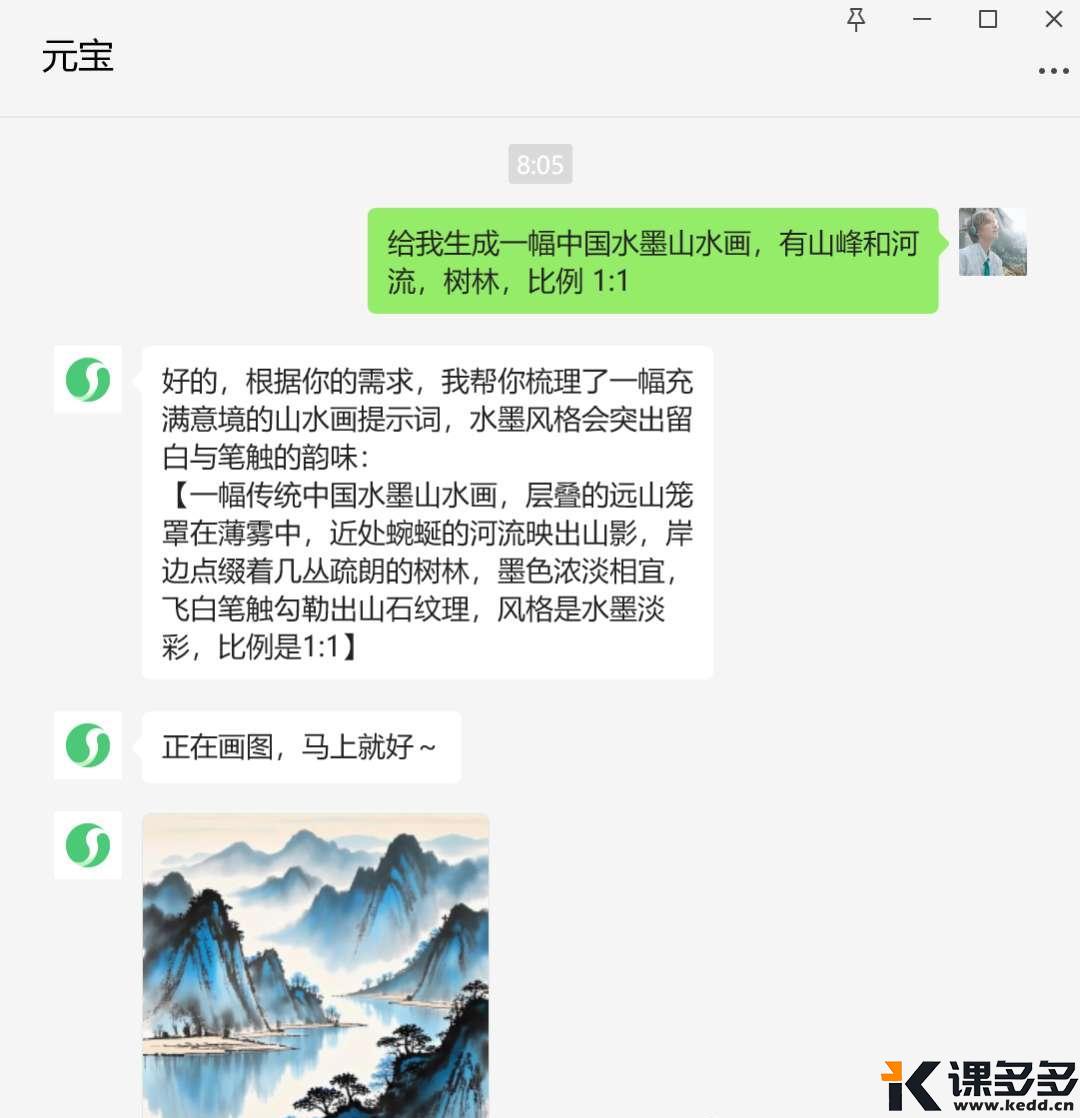

国内的豆包也不甘示弱,豆包的1.5深度思考模型也加入到了豆包家族。目前可以在火山调用相关的API。

豆包 1.5・深度思考模型包含两个版本:

1、基础大语言模型 Doubao-1.5-thinking-pro。 2、多模态视觉推理版 Doubao-1.5-thinking-pro-vision。

1的推理能力更强,2则是支持视觉推理。

o3、o4mini和豆包的最大共同点:都是能看懂图像、能调用工具的新一代推理模型。

豆包家族的两位成员也升级了。

豆包视觉理解模型增强了视觉定位能力和视频搜索能力。

豆包文生图模型正式升级到 3.0版本。如同即梦3.0一样,具备更好的文字排版表现、更真实的图像生成效果、直出2K 高清图片。

这里葉子简单解释一下关于模型的一个问题,也是不少小伙伴问我的。

葉子并不是专业人士,基于自己的理解让大家更好的看懂。

以往的模型可以大致分为两类,基座模型和推理模型。

基座模型就是啥都能聊,一开始只能文本,慢慢向多模态发展,开始支持语音图片视频等输入输出。

是为了可以跨模态的理解与生成,比如图文互译,视频解析等等。

我们经常用的像GPT-4.5、Gemini 2.0、DeepSeek-V3、混元、豆包这些。

而推理模型就是单独加强了推理能力,现在叫深度思考。

是为了做更复杂的逻辑推理。比如数学证明,代码生成这些。

我们常用的像DeepSeek-R1、混元T1、o1、豆包深度思考这些。

基于以上简单解释。

大家应该可以比较清晰的了解,o3、o4mini和豆包的更新代表着什么。

年初的DeepSeek-R1引领了深度思考模型的热潮,但是其实DeepSeek-R1并不是第一个深度思考模型。

但是接着DeepSeek的热度,国内的模型基本都上新了深度思考模型。

现在o3、o4mini和豆包的更新让大模型再次进入了一个新的时代——推理模型的多模态时代。

推理模型不再是简单的文本,而是可以进入到开始支持语音、图片、视频的领域。也可以完成更为复杂的、更为专业的场景中。

可以说,多模态推理更趋近真正的人类了。

下一步的路,更近了。

暂无评论内容